T2I 拡散モデルの設計メモ

目次

- 概要

- クラウド GPU

- テキストエンコーダー

- VAE

- GAN

- コンディショニング

- 位置埋め込み

- 目的関数

- Transformer アーキテクチャ

- Transformer を使わないアーキテクチャ

- Gated MLP

- ブロック図

- データセット

- キャプショニング

- スケジューラー

- 学習方法

- Classifier Free Guidance

- Adaptive Projected Guidance

- Reinforcement Learning Guidance

- タイムステップスケジューラー

- ノイズスケジューラー

- 蒸留

- 画像編集

- 省メモリ学習

- 性能検証

- 高速化

- ワーキングメモリー

- 教師ありファインチューニング

- 強化学習

- 丸暗記の仕組み

概要

拡散モデルのまとめは The Principles of Diffusion Models を参照。

クラウド GPU

ローカルでスモールモデルの検証を行い、本番はクラウドを使うのがコスパがよい。Runpod は先払いも選択でき、過払いの心配がない。

H100 や B200 のような業務用 GPU なら NEBIUS や Lambda がある。

料金は以下の3つの合計であることに注意する。少額の利用の場合、ストレージ料金や通信料の方が高額になりやすい。

- GPU のレンタル料金

- ストレージ利用料

- 通信料

| サービス名 | 最小チャージ金額 | A6000 48GB/hr | A5000 24GB/hr |

|---|---|---|---|

| runpod | $10 | $0.33 | $0.27 |

| vast.ai | $5 | $0.40 | $0.17 |

| CUDO | $0.40 | $0.29 | |

| OBLIVUS | $0.55 | ||

| Lambda | $0.80 |

テキストエンコーダー

CLIP や T5 が長らく使われてきたが、軽量 LLM を使うケースが増えている。

テキストエンコーダーのトークンの次元は重要だ。小さい拡散モデルはトークンの次元を小さくすることが多い。拡散モデルのトークンの次元を削減すると、テキストエンコーダーのトークンの次元も Linear 等で削減する必要があり、テキストの追従性が低下する。

| LLM・VLM | モデル |

|---|---|

| phi-3 | OmniGen |

| Qwen2.5-VL-3B-Instruct | OmniGen2 |

| Qwen2.5-VL-7B-Instruct | Qwen Image |

| Qwen3-VL-4B-Instruct | Z-Image |

| Gemma 2 | Lumina-Image 2.0, SANA |

| Llama3-8B | Playground v3 |

主な LLM と VLM

Is GPT-OSS Good? A Comprehensive Evaluation of OpenAI's Latest Open Source Models によると 120b より 20b の方が LLM の評価に使われる複数のベンチで性能が良い。gpt-oss-20b より Gemma 3 27b の方が性能が良い。phi-4-reasoning は 14b で gpt-oss-20b や Gemma 3 27b を上回るスコアを出してる。

Unsloth を使うと省メモリで LLM を学習できる。OpenAI GPT-OSS 20Bモデルのファインチューニング完全ガイド。

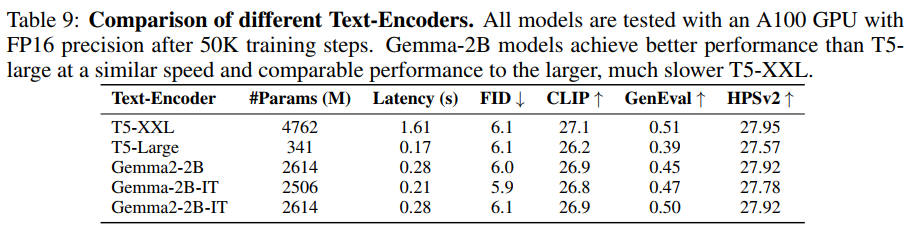

性能比較

Params(M) は間違いで、数値は FP32 精度の時のファイルサイズ

出典:SANA: Efficient High-Resolution Text-to-Image Synthesis with Linear Diffusion Transformers. Enze Xie et al. Table 9. https://openreview.net/forum?id=N8Oj1XhtYZ

むしろ T5-Large がコスパがよい。fp16(性能劣化なし)だと 1.6GB、GGUF Q8_0 量子化すると 900MB になる。

T5-XXL を使うよりは軽量 LLM の方が速いし性能もよい。

T5 と LLM を混ぜて使う場合は注意が必要だ。T5 は LLM に比べて出力の分散が小さい。なので LLM の出力に RMSNorm などの Normalization レイヤーが必要になる。

参考文献

Unified Multimodal Understanding via Byte-Pair Visual Encoding。画像にも byte-pair encoding を適用する。

VAE

なぜ KL VAE を使うのか

潜在空間の統計的制御(規則性)

KL loss を入れることで、潜在空間に意味的なスムーズさや構造性が生まれる。以下のような特徴を持つ潜在空間は拡散モデルにとって扱いやすい。

- 同じ意味を持つ画像は近い z にエンコードされる

- ノイズを加えてもデコーダーが画像として再構成しやすい

- 正規分布に従うことで、サンプリング可能な「全体的に埋まった」潜在空間になる

VAE のトリレンマ

以下の3つを同時に満たす VAE を作成するのは難しい。

- 拡散モデルの解釈容易性。latent が解釈しやすく圧縮されていると拡散モデルの性能が上がる

- 再構成品質

- 圧縮率

圧縮率を上げると品質は下がる。

VAE の再構成品質を上げると解釈容易性が下がり、拡散モデルの性能が下がる。

解釈容易性を上げるには

- チャンネルサイズを小さくする。すると圧縮率は犠牲になる

- KL 正則化を上げる。すると画像がボケる

- 現在の最適解は REPA や DINOv2 で正則化すること

詳細は FLUX.2 VAE を参照。

VAE の圧縮率

VAE の圧縮率を決めるパラメータは2つある。

- F:解像度の縮小率

- C:潜在空間のチャンネル数

拡散モデルの隠れ層の次元はさらにパッチサイズが関係している。

- P:パッチサイズ

VAE の隠れ層の次元数は以下のようになる。

\[{H \times W \times 3 \rightarrow \dfrac{H}{F} \times \dfrac{W}{F} \times C}\]拡散モデルの隠れ層の次元は以下のようになる。

\[{H \times W \times 3 \rightarrow \dfrac{H}{PF} \times \dfrac{W}{PF} \times (C \times P^2)}\]各 VAE の設定

| モデル | F | C | P |

|---|---|---|---|

| SD1.5 | F8 | C4 | P2 |

| SANA | F32 | C32 | P1 |

| SDXL | F8 | C4 | P2 |

| Dit-Air | F8 | C8 | P2 |

| SD3 FLUX.1 Lumina-Image-2.0 Qwen Image | F8 | C16 | P2 |

| モデル | エンコーダー パラメータ数 | デコーダー パラメータ数 |

|---|---|---|

| SD3 FLUX.1 Lumina-Image-2.0 | 34M | 50M |

| Qwen Image | 54M | 73M |

Transformer の隠れ層の次元 >> C なので、既存の VAE の P を大きくすれば、トークン数が減るので拡散モデルの処理速度を向上させられる。

DC-AE 1.5 の論文で述べられているように、VAE のチャンネル数を上げると VAE の性能は上がるが、DiT の性能は低下する傾向にあった。VAE の性能を上げつつ、DiT が解釈しやすい latent のデータ構造をとるように VAE を学習するのは難しい。詳細は DC-AE 1.5 の論文を参照。

SD-VAE・FLUX.1 VAE のレイヤー情報

Notes / Links about Stable Diffusion VAE

SDXL の VAE のレイヤー情報は sdxl-vae/config.json を参照。

SD3 の VAE や FLUX.1 の VAE にアクセスするには認証が必要。

Diffusers で様々な VAE の実装が見れる。

SD や FLUX は Diffusers の AutoencoderKL を使用しているので以下のコードで簡単にモデルを構築できる。学習するコードも 100 行程度あれば可能。block_out_channels は最終的には [128, 256, 512, 512] を使うことが多い。

AutoencoderKL を定義するコード

from diffusers.models import AutoencoderKL

F = 8

C = 16

resolution = 1024

model = AutoencoderKL(

sample_size=resolution,

in_channels=3,

out_channels=3,

latent_channels=C,

block_out_channels=[

int(resolution/F),

int(resolution/4),

int(resolution/2),

int(resolution/2)

],

layers_per_block=2,

down_block_types=[

"DownEncoderBlock2D",

"DownEncoderBlock2D",

"DownEncoderBlock2D",

"DownEncoderBlock2D"

],

up_block_types=[

"UpDecoderBlock2D",

"UpDecoderBlock2D",

"UpDecoderBlock2D",

"UpDecoderBlock2D"

],

act_fn="silu",

scaling_factor=0.18215,

mid_block_add_attention=True

)

VAE を学習させるコード

# train

optimizer = torch.optim.AdamW(model.parameters(), lr=learning_rate)

device = torch.device('cuda:0') if torch.cuda.is_available() else torch.device('cpu')

model.to(device)

model.train()

for i, (x, labels) in enumerate(train_loader):

x = x.to(device)

# encode

posterior = model.encode(x).latent_dist

latent_representation = posterior.sample()

# decode

# tanh で出力の範囲を [-1, 1] に制限

reconstructed_x = torch.tanh(model.decode(latent_representation).sample)

# loss

reconstruction_loss = F.mse_loss(reconstructed_x, x, reduction="sum")

kl_loss = torch.mean(posterior.kl())

vae_loss = reconstruction_loss + kl_loss

# back propagation

optimizer.zero_grad()

vae_loss.backward()

optimizer.step()

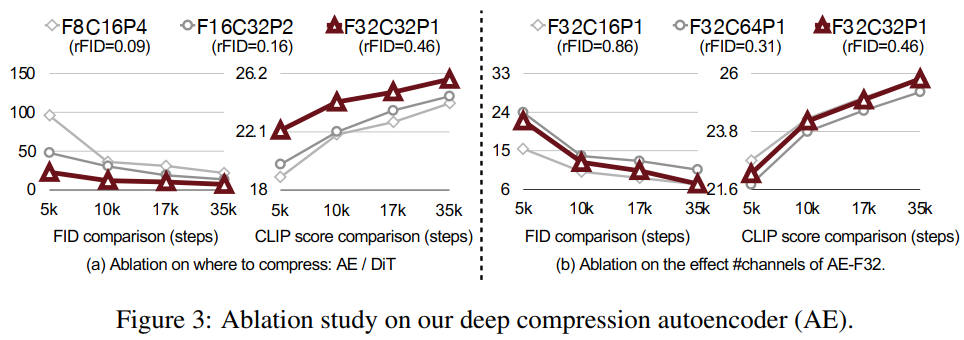

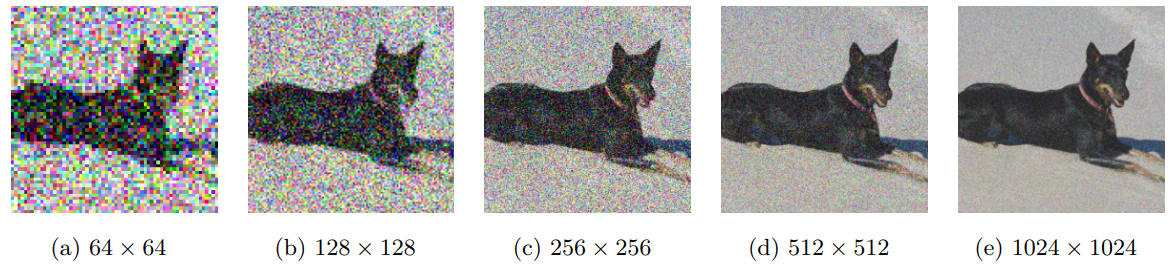

パッチサイズは小さい方が拡散モデルの性能が良い

パッチサイズは VAE の性能とは関係がない。パッチ処理があると拡散モデルが余計な処理をしないといけないので、拡散モデルの性能がわずかに低下する。

ただし MicroDiT はパッチマスクを行う前に Patch-mixer でテキスト Embedding を取り込むことで性能を向上させている。

パッチサイズは小さい方が拡散モデルの性能が良い

出典:SANA: Efficient High-Resolution Text-to-Image Synthesis with Linear Diffusion Transformers. Enze Xie et al. Figure 3. https://openreview.net/forum?id=N8Oj1XhtYZ

UNILIP: ADAPTING CLIP FOR UNIFIED MULTIMODAL UNDERSTANDING, GENERATION AND EDITING

CLIP を2つ使い、片方を学習可能する。

D2iT

D2iT は圧縮率の異なる2つの潜在空間表現にエンコード可能な VAE を使う。ディティールの細かい部分は低圧縮率、情報の少ない部分は高圧縮率と使い分ける。デノイザもディティールの細かい部分は多くのネットワークが通過する。

DC-AE Deep Compression Autoencoder for Efficient High-Resolution Diffusion Models

2025 年以降に発表された DiT でよく使われる。SANA や Nitro-T で使われている。space-to-channel, channel-to-space(要はパッチとアンパッチ)を学習可能な残差接続と、3段階の学習で性能を向上させる。

- 低解像度でエンコーダーとデコーダーを学習させる

- 高解像度でエンコーダーの終わりとデコーダーの入り口とのみを学習させる

- 高解像度でデコーダーの終わりのみを学習させる

DC-AE は dc-ae-f32c32-sana-1.1-diffusers からダウンロードできる。モデルの定義は efficientvit。

DC-AE 1.5: Accelerating Diffusion Model Convergence with Structured Latent Space

VAE の圧縮率とチャンネル数とにはトレードオフがあった。VAE の圧縮率を上げて性能を維持するにはチャンネル数を増やすしかない。そうすると VAE の性能は上がるが、拡散モデルの性能は下がる。これは VAE の潜在空間に構造情報が拡散して保存されないことが原因だ。

潜在空間に情報を構造化して保存させるために、潜在空間ベクトルをチャンネルごとにマスクして学習させた。例えば、C=128 とすると、0~127 の乱数を生成し、その数字以下のチャンネルを使ってデコードさせる。これによって、VAE 前半に構造情報、後半にディティールを保存するようにした。

augmented diffusion objectives(拡散モデルで実際にノイズを予測させた loss を使う)を導入することで学習を高速化した。

CoVAE: Consistency Training of Variational Autoencoders

FLUX.2 VAE

VAE の学習

VAE の学習は簡単ではない。VAE 単体ではぼやけた画像にしかならない。

Stable DiffusionのVAEは、LPIPS、パッチベースのGAN損失、およびMSE損失を含む複雑な損失関数を使用して訓練される。この組み合わせにより、VAEは、ピクセル単位で正確 (MSE)、知覚的に整合 (LPIPS)、かつ全体的にリアル (GAN損失) な、高品質でぼやけのない再構成を生成できる。

taming-transformers は LPIPS と GAN とを使用して VQ-VAE を学習させており、VAE の作成の時に参考になる。

VIVAT: Virtuous Improving VAE Training through Artifact Mitigation は VAE の学習でよく起こるアーティファクトの対処法を解説している。

Generative modelling in latent space

posterior collapse

VAE は同じ画像ばかり出力する posterior collapse(KL loss が急速に0に近づく)が起こりやすい。そこで以下のような戦略が良く使われる。

- KL Loss の逆伝播の量を調整する kl_beta を設定する。

- 最初の数万ステップは kl_beta を0にする。

- 次にウォームアップ区間を設ける。 kl_beta が 0→1 になる“ウォームアップ区間”は、実装・データ規模により 1 万〜10 万 SGD ステップ、あるいは 50〜200 エポック程度

- 各ピクセルの小さい loss を、ノイズとみなして、フィルターして無視する

- 各ピクセルの KL loss の最大値を設定する。max(KLi, threshold)

- ウォームアップ区間が短すぎると posterior collapse が起こりやすく、長すぎると訓練が停滞するため、近年では「1〜2% の総ステップ数をウォームアップに割く」か「 ELBO が安定するまでβを上げない」設計が主流

- 最低でも1万ステップのウォームアップ期間が必要。高解像度画像・映像用 VAE では 2.5〜5 万ステップ程度の長めのウォームアップが採用される傾向があり、テキスト VAE では 1〜2 万ステップ前後が多い

- posterior.mean を可視化して、すべて 0 近辺になっている場合、posterior collapse の疑いが強い

prior hole problem

VAE の潜在空間(latent space)において、事前分布(通常は標準正規分布)に従ってサンプリングした点が、まともな出力を生成できないことがあるという問題。エンコーダーが潜在空間 z の全体を使用していないことが原因。

対策

- VAE with a VampPrior

- KL loss の重みを適切に調整(例: KL annealing)

- beta VAE の β を高める(GAN や LPIPS を使わないと画像がぼける)

- デコーダーの能力を上げる(ただし posterior collapse が起こりやすくなる)

- Two-stage VAE などの構造的改良(例: hierarchical VAE)

正規化

画像の表示時や保存時に逆正規化を忘れるのはよくやりがちだ。

transforms.Normalize([0.5], [0.5]) # 訓練画像の正規化 x = (x * 0.5 + 0.5).clamp(0, 1) # 逆正規化

MSE 単体では目的関数として力不足

The reasonable ineffectiveness of pixel metrics for future prediction (and what to do about it)

- ぼやけた画像は MSE が小さいことが多い。ぼやけた画像は位置の微妙な変化にも対応できる

- 最尤推定は訓練データとは著しく異なるデータを生成してもペナルティがない

正則化項

- KL。KL VAE はオートエンコーダーに KL 正則化項を追加したもの

- LPIPS

- GAN

- Masked AutoEncoders

- EQ-VAE

- Watsonの知覚モデル。離散フーリエ変換 (DFT) 等を使い特徴を抽出。LPIPS より6倍高速で、省メモリ

- 輪郭情報。Unleashing the Power of One-Step Diffusion based Image Super-Resolution via a Large-Scale Diffusion Discriminator

- そのほかは画像比較手法まとめを参照

LPIPS

LPIPS の損失の計算をするコード

import lpips

# LPIPS の準備('vgg' or 'alex')

lpips_fn = lpips.LPIPS(net='vgg').to(device)

lpips_fn.eval() # 推論モード

for epoch in range(num_epochs):

for i, (x, labels) in enumerate(train_loader):

x = x.to(device)

# encode

posterior = model.encode(x).latent_dist

latent_representation = posterior.sample().float()

# decode

# [-1, 1] に正規化

reconstructed_x = torch.tanh(model.decode(latent_representation).sample)

# loss: MSE

reconstruction_loss = F.mse_loss(reconstructed_x, x, reduction="sum")

# loss: KL

kl_loss = torch.mean(posterior.kl())

# loss: LPIPS

# LPIPS に入力する画像は [-1, 1] に正規化されている必要がある

lpips_loss = lpips_fn(x_norm, reconstructed_x).mean()

# AMP を使う場合は lpips の計算中は AMP を無効にする

# with autocast('cuda', enabled=False):

# lpips_loss = lpips_fn(x.float(), reconstructed_x.float()).mean()

# 総合 loss

vae_loss = reconstruction_loss + kl_loss + lpips_lambda * lpips_loss

optimizer.zero_grad()

vae_loss.backward()

optimizer.step()

lpips の動作は以下のコードで検証できる。> 0.1 なら lpips は正常。

x_noise = x + torch.randn_like(x) * 0.1

x_noise = torch.clamp(x_noise, 0.0, 1.0)

x_norm = x * 2 - 1

x_noise_norm = x_noise * 2 - 1

lpips_test = lpips_fn(x_norm, x_noise_norm)

EQ-VAE: Equivariance Regularized Latent Space for Improved Generative Image Modeling

EQ-VAE は SD-VAE が同変性(equivariance)を持たないことに注目し、スケール・回転変換を使った正則化で高画質を実現した。入力を変換したものと、潜在空間表現を変換したものをデコードしたものとの再構成 loss をとる。

以下の式で $ \tau$ はスケール・回転変換、$ \mathcal{E}$ はエンコーダー。$ \mathcal{L}_{rec}$ は再構成 loss。$ \mathcal{L}_{reg}$ は KL loss。エンコーダーで変換する画像は、スケール・回転変換しないことに注意。

\[ \mathcal{L}_{EQ-VAE}(x, \tau) = \mathcal{L}_{rec}(\tau \circ \mathbf{x}, \mathcal{D}(\tau \circ \mathcal{E}(\mathbf{x}))) + \lambda_{gan}\mathcal{L}_{gan}(\mathcal{D}(\tau \circ \mathcal{E}(\mathbf{x}))) + \lambda _{reg}\mathcal{L}_{reg} \]潜在空間表現の回転と拡大縮小するコードは以下のようになる。潜在空間表現は3次元 [C, H, W] である必要がある。

import random

# 普通はスケールしてから回転させるが、このコードでは回転させてからスケールしている

def rot_scale(x, angle, size):

# x.shape = [B, C, H, W]

x_s = torch.nn.functional.rotate(latent, angle)

return torch.nn.functional.interpolate(

x_s,

size=size,

mode='bicubic', # 'nearest', 'bilinear', 'bicubic' などが選択可能

align_corners=False # デフォルトはFalse。Trueにすると端のピクセルのアライメントが変わる

)

angle = 90 * random.randint(0, 3) # angle = 0, 90, 180, 270

size = (random.uniform(0.25, 1.0), random.uniform(0.25, 1.0)) # sx, sy = 0.25~1.0

x_rs = rot_scale(x, angle, size)

latent_rs = rot_scale(encoder(x), angle, size)

reconstructed_x = decoder(latent_rs)

reconstruction_loss = F.mse_loss(reconstructed_x, x_rs, reduction="sum")

Latent Diffusion Models with Masked AutoEncoders

Masked Autoencoders に KL 項を追加して、潜在空間のスムースさ・知覚的圧縮品質・再構成画像の品質の3つの指標を同時に達成。Loss は以下の4つ。

- マスクしていない部分の再構成 loss

- マスク部分の再構成 loss

- マスクしていない部分の LPIPS loss

- マスクしていない部分の KL loss

対称形の ViT ベースのエンコーダーとデコーダーとを採用している。SD-VAE がファイルサイズ 320MB に対して VMAE は 43MB で、性能で SD-VAE を上回る。

F4C16 のモデルの処理は以下のようになる。Transformer の次元は dmodel とする。Transformer は Transformerエンコーダの単一の層(Multi-Head Self-AttentionとFeed-Forward Network) のみの torch.nn.TransformerEncoderLayer が便利。

- 元画像(3 x 512 x 512)

- 画像のパッチ化によるダウンサンプル(3 x 512 x 512)->(64 x 128 x 128)-> (16,384 x 64)

- Linear で隠れ層の次元を調整 (16,384 x 64) ->(16,384 x dmodel)

- Transformer

- Linear 等で ${\mu}$ と ${\sigma}$ とを計算(それぞれ(16,384 x 16))

- z をサンプリング(z.shape =(16,384 x 16))

- Linear(16,384 x 16)->(16,384 x dmodel)

- Transformer

- Linear で隠れ層の次元を調整 (16,384 x dmodel) -> (16,384 x 64)

- アンパッチ (16,384 x 64) -> (64 x 128 x 128)->(3 x 512 x 512)

Transformer VAE の設計

Transformer VAE は出力がブロック状になりやすい。原因は、Transformer のパッチ化と KL loss との2つ。

KL loss 対策

- ステップ数が十分か確かめる。ブロック感をなくすには 50 万ステップは必要

- β-VAE を採用し、ベータを抑え気味にする

パッチ化対策

- 学習可能な位置エンコーディングを使う

- VIVAT: Virtuous Improving VAE Training through Artifact Mitigation

- トランスフォーマーブロックは最低でも8は必要

- パッチ化に畳み込みを使いオーバーラップさせる

- デコーダーの最後に refiner の畳み込みを追加する

オーバーラップのサンプルコード

self.image_to_token_cnn = nn.Conv2d(

in_channels=3,

out_channels=model_dim,

kernel_size=patch_size,

stride=patch_size//2, # stride < kernel_size → オーバーラップあり

padding=patch_size//4

)Refiner のサンプルコード

self.reconstruction_refiner = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=3, padding=1),

nn.ReLU(),

nn.Conv2d(64, 3, kernel_size=3, padding=1)

)

# after rearrange

img = self.reconstruction_refiner(img)参考文献

Self-Guided Masked Autoencoder

Masked Autoencoders Are Scalable Vision Learners

MaskGIT: Masked Generative Image Transformer

MAGE: MAsked Generative Encoder to Unify Representation Learning and Image Synthesis

Latent Denoising Makes Good Visual Tokenizers

MVAE のように入力画像をマスクした上に、潜在空間表現にノイズを乗せてデコーダーを学習させる。MVAE の loss に加えて GAN も使う。

補間ノイズ $ x' = (1-\tau)x + \tau \epsilon$ と加算ノイズ $ x' = x + \tau \epsilon$ とでは補間ノイズの方が性能がよかった。$ \epsilon(\gamma) \sim \gamma \cdot \mathcal{N}(\mathbf{0},\mathbf{I})$ で $ \gamma = 3$ が最も性能がよかった。加算ノイズはオリジナルのシグナルを損なわないようなショートカットが作成される恐れがある。それにも関わらず VAR では性能が改善されたが、SiT では性能は改善されなかった。

マスク率は 70~90% が性能が高い。マスク率をランダム化した方が性能が良い。

マスクと潜在空間ノイズとを併用すると VAR では性能が上がったが SiT では性能が上がらなかった。SiT の場合は、マスクはしなくてもいい。

エンコーダーをフリーズしてデコーダーを訓練させたところ性能が劣化した。つまり、エンコーダーの能力強化が VAE の性能を上げるうえで重要。

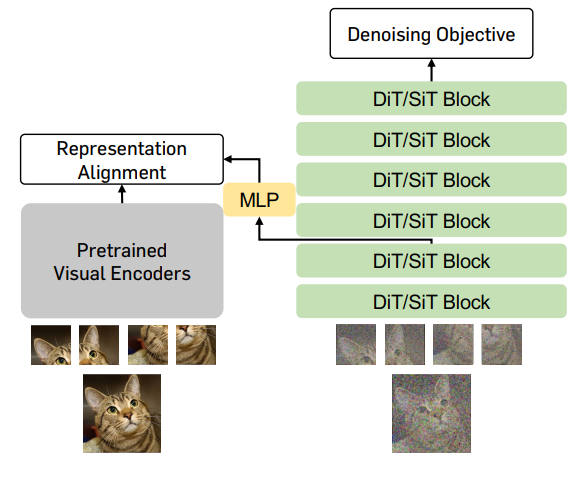

REPA-E

REPA-E: Unlocking VAE for End-to-End Tuning with Latent Diffusion Transformers REPA を使用し、VAE と拡散モデルとを同時に学習させることで、品質を向上させかつ学習速度も高速化する。

VAE 学習の参考文献

Community Training AutoencoderKL #894

Cyclical Annealing Schedule: A Simple Approach to Mitigating KL Vanishing (pdf)

Summary: Beta-VAE: Learning Basic Visual Concepts with a Constrained Variational Framework

beta-VAE: Learning Basic Visual Concepts with a Constrained Variational Framework

Taming Transformers for High-Resolution Image Synthesis

The Unreasonable Effectiveness of Deep Features as a Perceptual Metric

Deep Compression Autoencoder for Efficient High-Resolution Diffusion Models

ALVAE Adversarial Latent Autoencoders

AS-VAE Adversarial Symmetric Variational Autoencoder

A Loss Function for Generative Neural Networks Based on Watson's Perceptual Model

参考文献

Conditional VAE Semi-Supervised Learning with Deep Generative Models

Deep Compression Autoencoder for Efficient High-Resolution Diffusion Models

VQ-VAE

VQ-VAE Neural Discrete Representation Learning

Generating Diverse High-Fidelity Images with VQ-VAE-2

SoftVQ-VAE: Efficient 1-Dimensional Continuous Tokenizer

Quantize-then-Rectify: Efficient VQ-VAE Training

Instella-T2I: Pushing the Limits of 1D Discrete Latent Space Image Generation。1次元バイナリ潜在空間に圧縮することで VQ-VAE 比で 32 倍の圧縮率を達成している。

VQ-Diffusion Vector Quantized Diffusion Model for Text-to-Image Synthesis。VQ-VAE は量子化されているので、小さなミスが大きな意味の変化へつながる恐れがある。VQ-Diffusion では Mask-and-replace という学習手法でその問題に対処している。

AR

DC-AR: Efficient Masked Autoregressive Image Generation with Deep Compression Hybrid Tokenizer

NextStep-1: Toward Autoregressive Image Generation with Continuous Tokens at Scale

GAN

GAN は拡散モデルの主要技術ではないが、VAE の学習や蒸留のときに必要になる。

GAN の学習についてはGAN の学習を参照。

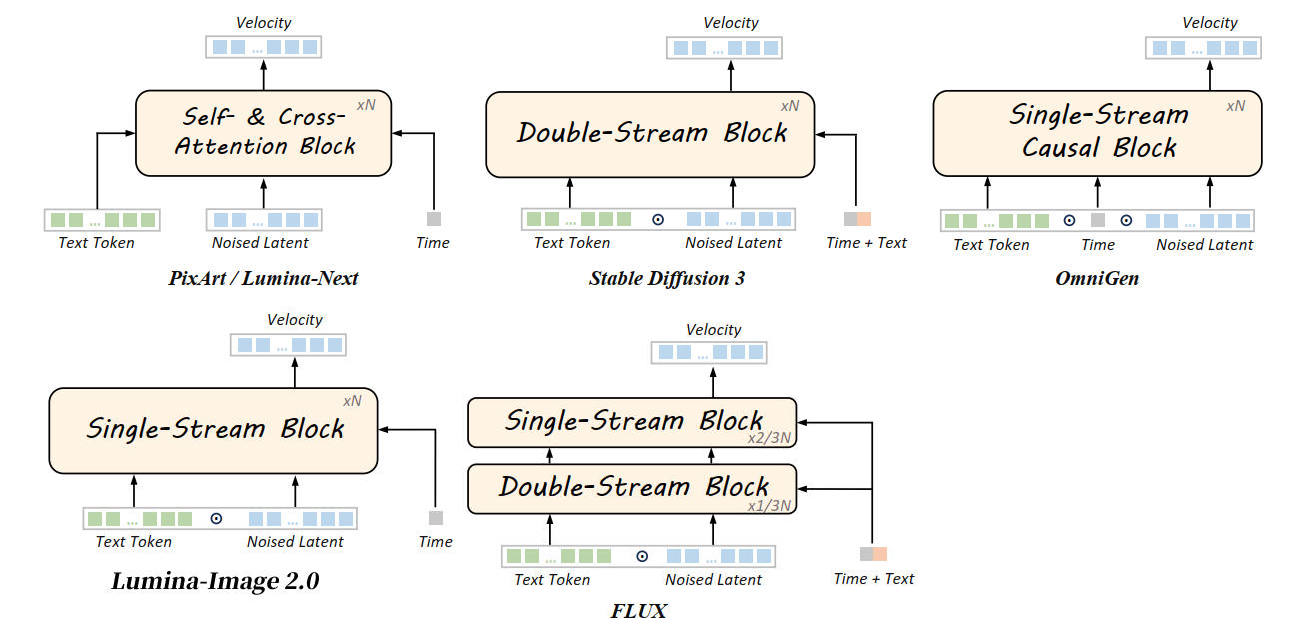

コンディショニング

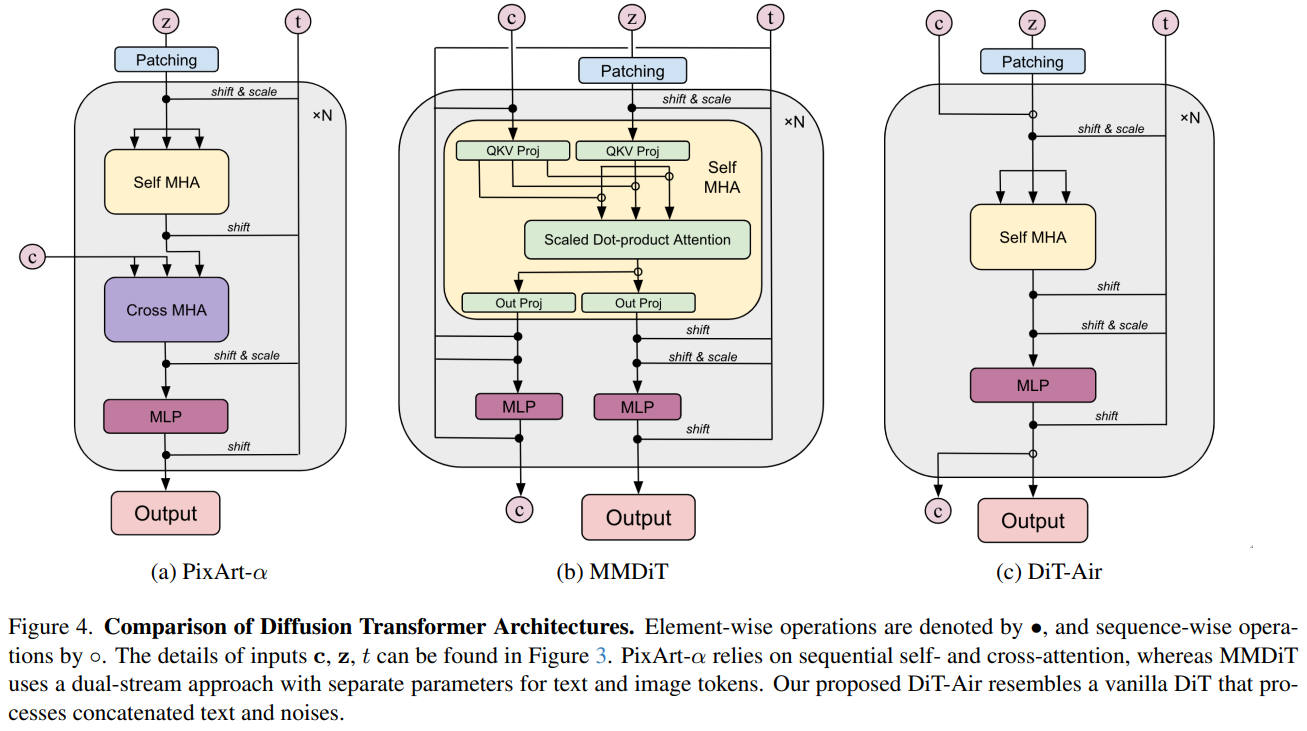

拡散トランスフォーマーではタイムステップをコンディショニングする。キャプションをコンディショニングする場合もあるが、拡散トランスフォーマーではキャプションはノイズ画像と結合して入力されることが多い。

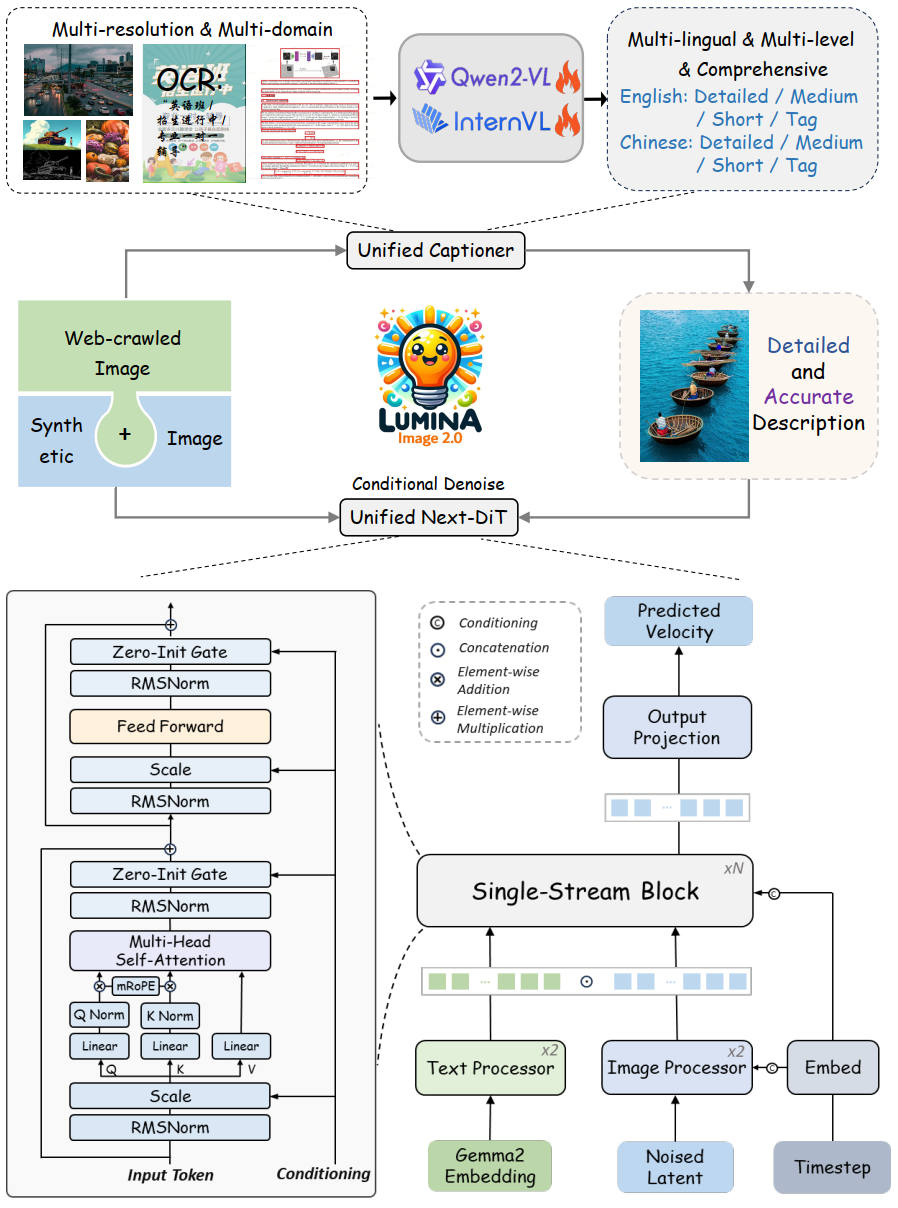

出典:Qi Qin et al. Lumina-Image 2.0: A Unified and Efficient Image Generative Framework. Figure 3.

https://arxiv.org/abs/2503.21758

図の位置の改変は筆者

タイムステップは AdaLN でコンディショニングする。

キャプションはクロスアテンション(SD3, PixArt-α, Hunyuan-DiT, SANA, FLUX, HiDream-I1)かセルフアテンション(OmniGen, FLUX, Lumina-Image 2.0, DiT-Air, Qwen-Image)で取り込む。

DiT-Air: Revisiting the Efficiency of Diffusion Model Architecture Design in Text to Image Generation によると、クロスアテンションよりノイズ画像と結合してセルフアテンションでキャプションを取り込む方が、パラメータ効率が良い。

結合

モデルの隠れ層の次元が dmodel で、テキストエンコーダーの出力 T が [nt, dt] で、潜在空間の画像の次元 IMG が [ni, di] とする。

これらを結合するには Linear などで、T と IMG の隠れ層の次元を dmodel に変換する必要がある。

t_hidden = self.fc_t(T) # [n_t, d_t] -> [n_t, d_model]

img_hidden = self.fc_img(IMG) # [n_i, d_i] -> [n_i, d_model]

input = torch.cat([img_hidden, t_hidden], dim=0) # 実際はバッチサイズがあるので dim=1 になる

print(input.shape) # [n_t + n_i, d_model]

# 分離

img = [:n_i, :] # [n_i, d_model]

t = [n_i:, :] # [n_t, d_model]

Mod

\[x_{out} = x_{in} \odot (1 + \gamma) + \beta\]AdaLN

Layer Nomalization のガンマとベータは学習可能なパラメータだ。AdaLN はこれを線形変換などを使用して動的に変更するもの。つまり

c = タイムステップなど γ = Linear(c) β = Linear(c)\[ \displaylines{ \mathrm{LN}(x) = \gamma \odot \dfrac{x - \mu}{\sigma} + \beta \\ {\mathrm{Layer Normalization} の数式} } \]\[ \displaylines{ \mathrm{AdaLN}(x, c) = \gamma (c) \odot \dfrac{x - \mu}{\sigma} + \beta (c) \\ {\mathrm{AdaLN} の数式。c \;はプロンプトやタイムステップ等} } \]

AdaLN のサンプルコード

import torch

import torch.nn as nn

class AdaLN(nn.Module):

def __init__(self, embed_dim, style_dim):

super().__init__()

self.norm = nn.RMSNorm(embed_dim)

self.proj = nn.Linear(style_dim, 2 * embed_dim) # Scale and Shift

def forward(self, x, style):

scale, shift = self.proj(style).chunk(2, dim=-1)

scale = scale.unsqueeze(1)

shift = shift.unsqueeze(1)

return self.norm(x) * (1 + scale) + shift

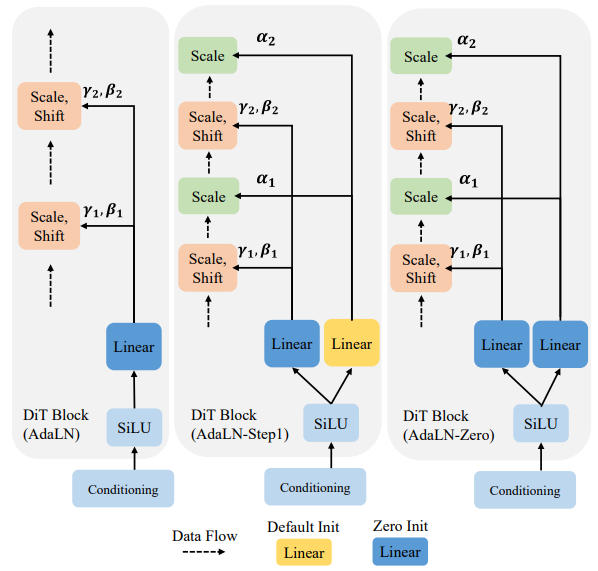

ブロック図での表記法

- Scale & Shift:Scale & Shift とだけ書かれていても、AdaLN の場合がある

- LayerNorm の後に Scale, Shift

- LayerNorm の後に Mod

Unveiling the Secret of AdaLN-Zero in Diffusion Transformer

ゼロではなくガウス分布を利用した初期化をする adaLN-Gaussian を提唱している。

位置埋め込み

画像生成 AI の位置埋め込みには2種類ある。セルフアテンションで使われる RoPE と画像のタイムステップ埋め込みとだ。

可変解像度に対応するには位置埋め込みに加え、畳み込みか Attention かを使う必要がある。

ViT の RoPE については Rotary Position Embedding for Vision Transformer が詳しい。

タイムステップ埋め込み(Sinusoidal Encoding)

ノイズ画像や教師画像にタイムステップの埋め込みをすることが多い。スカラーのタイムステップを Sinusoidal Encoding で隠れ層の次元へ拡張し、シーケンス長の個数だけ複製して潜在ノイズと可算する。

Timestep を Sinusoidal Encoding するコード

import torch

import math

def get_timestep_embedding(

timesteps: torch.Tensor,

embedding_dim: int,

flip_sin_to_cos: bool = False,

downscale_freq_shift: float = 1,

scale: float = 1,

max_period: int = 10000,

) -> torch.Tensor:

"""

This matches the implementation in Denoising Diffusion Probabilistic Models: Create sinusoidal timestep embeddings.

Args:

timesteps (torch.Tensor): a 1-D Tensor of N indices, one per batch element

embedding_dim (int): the dimension of the output

flip_sin_to_cos (bool): Whether the embedding order should be `cos, sin` (if True) or `sin, cos` (if False)

downscale_freq_shift (float): Controls the delta between frequencies between dimensions

scale (float): Scaling factor applied to the embeddings

max_period (int): Controls the maximum frequency of the embeddings

"""

assert len(timesteps.shape) == 1, "Timesteps should be a 1d-array"

half_dim = embedding_dim // 2

exponent = -math.log(max_period) * torch.arange(

start=0, end=half_dim, dtype=torch.float32, device=timesteps.device

)

exponent = exponent / (half_dim - downscale_freq_shift)

emb = torch.exp(exponent)

emb = timesteps[:, None].float() * emb[None, :]

# scale embeddings

emb = scale * emb

# concat sine and cosine embeddings

emb = torch.cat([torch.sin(emb), torch.cos(emb)], dim=-1)

# flip sine and cosine embeddings

if flip_sin_to_cos:

emb = torch.cat([emb[:, half_dim:], emb[:, :half_dim]], dim=-1)

# zero pad

if embedding_dim % 2 == 1:

emb = torch.nn.functional.pad(emb, (0, 1, 0, 0))

return emb

RoPE の前に APE と RPB の復習

Absolute Positional Embedding

入力サイズが固定の時に使える。APE を sinusoidal にするか学習可能なパラメータにするかすることで性能が上がる。

$\mathbf{x}_0 \in \mathbb{R}^{N \times d}, \mathrm{E}_{\mathrm{APE}} \in \mathbb{R}^{N\times d}$ とすると APE は以下の式になる:

\[ \mathbf{x}_0^\prime = \mathbf{x}_0 + \mathrm{E}_{\mathrm{APE}} \]sinusoidal

1次元のシーケンス長 N を $\sqrt{N} \times \sqrt{N}$ のグリッド $(p_x, p_y)$ として解釈し、4t の周期でループする。やっていることは $p_x, p_y$ にそれぞれ sinusoidal encoding を適用しているだけだ。

位置 $\mathbf{p}_n = (p_n^x, p_n^y)$ を $\mathrm{E}_{\mathrm{APE}}(\mathbf{p}_n) \in \mathbb{R}^d$ と表記すると t の位置 の sinusoidal 埋め込み $\mathrm{E}_{\mathrm{APE}}(\mathbf{p}_n, t)$ は:

\[ \large{ \begin{split} \mathrm{E}(\mathbf{p}_n, &4t) &= \mathrm{sin}(p_n^x/10^{4t/\lfloor \frac{d}{4} \rfloor})\\ \mathrm{E}(\mathbf{p}_n, &4t+1) &= \mathrm{cos}(p_n^x/10^{4t/\lfloor \frac{d}{4} \rfloor})\\ \mathrm{E}(\mathbf{p}_n, &4t+2) &= \mathrm{sin}(p_n^y/10^{4t/\lfloor \frac{d}{4} \rfloor})\\ \mathrm{E}(\mathbf{p}_n, &4t+3) &=\mathrm{cos}(p_n^y/10^{4t/\lfloor \frac{d}{4} \rfloor})\\ \end{split} } \]実装例

import torch

import math

def get_2d_sinusoidal_ape(h, w, d, device="cpu"):

# h, w: グリッドの高さと幅 (h * w = N), d: 埋め込み次元

assert d % 4 == 0, "Dimension d must be divisible by 4"

# meshgrid を使ってグリッド上の x 座標と y 座標を生成

grid_y, grid_x = torch.meshgrid(torch.arange(h), torch.arange(w), indexing="ij")

grid_x = grid_x.reshape(-1, 1) # p_n^x (N, 1)

grid_y = grid_y.reshape(-1, 1) # p_n^y (N, 1)

# 10^(4t / (d/4)) の計算。実質 base = 10000 (10^4)

t = torch.arange(0, d // 4, device=device).float()

inv_freq = 1.0 / (10 ** (4 * t / (d // 4)))

# 各成分の計算

pe = torch.zeros(h * w, d, device=device)

pe[:, 0::4] = torch.sin(grid_x * inv_freq) # 4t

pe[:, 1::4] = torch.cos(grid_x * inv_freq) # 4t+1

pe[:, 2::4] = torch.sin(grid_y * inv_freq) # 4t+2

pe[:, 3::4] = torch.cos(grid_y * inv_freq) # 4t+3

return pe

# 使用例 (例: 14x14のパッチグリッド、次元512)

h, w, d = 14, 14, 512

x = torch.randn(1, h * w, d) # (Batch, N, d)

pe = get_2d_sinusoidal_ape(h, w, d, x.device)

x_prime = x + peRelative Position Bias(RPB)

それぞれの絶対位置に学習可能なパラメータをもつ APE と違い、RPB は相対位置に対して学習可能なパラメータを持つ。つまり RPB テーブル T を、取り得る相対位置すべてに対し学習可能なパラメータ、として定義する:

\[ T = \{ T_{\tilde{p}^x \tilde{p}^y} \in \mathbb{R} \; | \; \tilde{p}^x \in \{ -W, ..., 0, ..., W \}, \tilde{p}^y \in \{ -H, ..., 0, ..., H \} \} \]RPB の適用

QK と softmax とを適用したアテンション行列 $\mathbf{A} \in \mathbb{R}^{N\times N}$ は qk ヘッドを $\mathbf{q}, \mathbf{k} \in \mathbb{R}^{N\times d_{head}}$ とすると:

\[ \mathbf{A} = \mathrm{SoftMax}(\mathbf{qk}^T / \sqrt{d_{head}}) \]RPB テーブルの次元は $T \in \mathbb{R}^{(2W+1)\;\times \;(2H+1)}$。アテンション行列の次元 $\mathrm{E}_{\mathrm{RPB}} \in \mathbb{R}^{N\times N}$ に合わせるために以下の計算を行う:

\[ \Large{ \mathrm{E}^{\mathrm{RPB}}_{nm} = T_{ \tilde{p}^x_{nm} \tilde{p}^y_{nm} } = T_{(p^x_n - p^x_m)(p^y_n - p^y_m)} } \]実装時には W, H のバイアスを加えて [0, W or H] の範囲に変換する。実際の実装では、毎回座標変換の計算をするのは非効率なため、あらかじめ相対座標に対応する「インデックス行列(定数)」を作っておき、それを使ってテーブル $T$ から一気に値を gather する手法が一般的。

最終的にアテンション行列と可算する:

\[ \begin{split} \mathbf{A} &= \mathrm{SoftMax}(\mathbf{qk}^T / \sqrt{d_{head}}) + \mathrm{E}_{\mathrm{RPB}} \; \textrm{もしくは} \\ \mathbf{A} &= \mathrm{SoftMax}(\mathbf{qk}^T / \sqrt{d_{head}} + \mathrm{E}_{\mathrm{RPB}}) \end{split} \]RPB テーブルを SoftMax の中にいれると、相対的に近いパッチ同士のスコアを(学習によって)強調したり弱めたりする効果が、確率分布に直接反映されるようになる。

マルチヘッドの数だけ RPB テーブルが必要になる。

RoPE

1D RoPE

1D RoPE は LLM で使われる。

RPB は qk 行列の乗算後の行列に可算していたので、query-key 類似度に影響を与えることができなかった。RoPE ではオイラーの法則 $(e^{i\theta})$ の乗算を利用することで、qk 行列に直接影響を与える。

n, m 番目の qk ベクトルを $\mathbf{q}_n, \mathbf{k}_m \in \mathbb{R}^{1 \times d_{\mathrm{head}}}$ とすると、RoPE は以下のように適用する:

\[ \begin{split} \mathbf{q}^\prime_n &= \mathbf{q}_n e^{in\theta} \\ \mathbf{k}^\prime_m &= \mathbf{k}_m e^{im\theta} \end{split} \]k に共役を適用すると、アテンション行列の (n, m) は以下のように計算できる:

\[ \begin{split} \mathbf{q}_ne^{in\theta} \cdot (\mathbf{k}_me^{im\theta})^* &= \mathbf{q}_ne^{in\theta} \cdot \mathbf{k}_m^* e^{-im\theta} = (\mathbf{q}_n \mathbf{k}_m^*)e^{i(n-m)\theta}\\ \mathbf{A}^\prime_{(n,m)} &= \mathrm{Re} \left[ \mathbf{q}^\prime_n \mathbf{k}^{\prime *}_m \right] = \mathrm{Re} \left[ \mathbf{q}_n \mathbf{k}^{*}_m e^{i(n-m)\theta} \right] \end{split} \]$\mathrm{Re}[\cdot ]$ は複素数の実部で、* は複素共役。トークン位置(n, m)に依存する複素回転 $e^{i\theta n}, e^{i\theta m}$ を掛けることで、相対位置(n - m)を回転形式でアテンション行列に注入できる。

実装する場合は、RoPE は $\mathbf{q}_n, \mathbf{k}_m \in \mathbb{R}^{1 \times d_{\mathrm{head}}}$ を複素ベクトル $\bar{\mathbf{q}}_n, \bar{\mathbf{k}}_m \in \mathbb{C}^{1 \times (d_{\mathrm{head}}/2)}$ に変換し、(2t) 番目の次元を実部、(2t+1) 番目の次元を虚部として扱う。$\mathbf{q}_n\mathbf{k}_m^T = \mathrm{Re}[\bar{\mathbf{q}}_n \bar{\mathbf{k}}_m^*]$ と同じアテンションの値を生成するが計算の無駄を減らせる。

kq の隠れ層の次元は RoPE の周波数に影響を与える:

\[ \theta_t = 10000^{-t(d_{\mathrm{head}/2})}, \mathrm{where} \; t \in \{ 0, 1, ..., d_{\mathrm{head}}/2 \} \]まとめると、回転行列 $\mathbf{R} \in \mathbb{C}^{N \times (d_{\mathrm{head}}/2)}$ は以下のように定義される:

\[ \mathbf{R}(n, t) = e^{i\theta_t n} \]アダマール積 $\circ$ を使用して、クエリベクトルとキーベクトルとに適用する:

\[ \begin{split} \bar{\mathbf{q}}^\prime &= \bar{\mathbf{q}} \circ \mathbf{R} \\ \bar{\mathbf{k}}^\prime &= \bar{\mathbf{k}} \circ \mathbf{R} \\ \mathbf{A}^\prime &= \mathrm{Re} \left[ \bar{\mathbf{q}}^\prime \bar{\mathbf{k}}^{\prime *} \right] \end{split} \]コード例

import torch

import math

# 毎回作成するのではなく、一度作成してキャッシュする

def build_rope_cache(

seq_len: int,

head_dim: int,

base: float = 10000.0,

device=None,

dtype=None,

):

"""

sin, cos cache を生成する

Returns:

cos, sin: [seq_len, head_dim // 2]

"""

assert head_dim % 2 == 0

half_dim = head_dim // 2

inv_freq = 1.0 / (base ** (torch.arange(0, half_dim, device=device, dtype=dtype) / half_dim)) # θ_t の計算

positions = torch.arange(seq_len, device=device, dtype=dtype)

freqs = torch.einsum("i,j->ij", positions, inv_freq) # 外積を利用して、nθ, mθ の計算

cos = torch.cos(freqs)

sin = torch.sin(freqs)

return cos, sin

def apply_rope(q: torch.Tensor, k: torch.Tensor, cos: torch.Tensor, sin: torch.Tensor):

"""

RoPE を q, k に適用する

B: batch size

H: head

S: sequence length

D: dimension

Args:

q, k : [B, H, S, D]

cos, sin : [S, D//2]

Returns:

q_rot, k_rot : [B, H, S, D]

"""

B, H, S, D = q.shape

assert D % 2 == 0

# [B, H, S, D//2, 2]

q = q.view(B, H, S, D // 2, 2) # q.shape = [B, H, S, D//2, 2]。dimension 次元を2分割

k = k.view(B, H, S, D // 2, 2)

cos = cos[None, None, :, :, None] # [1,1,S,D//2,1]

sin = sin[None, None, :, :, None]

# 回転

q_rot = torch.stack(

[

q[..., 0] * cos - q[..., 1] * sin,

q[..., 0] * sin + q[..., 1] * cos,

],

dim=-1,

)

k_rot = torch.stack(

[

k[..., 0] * cos - k[..., 1] * sin,

k[..., 0] * sin + k[..., 1] * cos,

],

dim=-1,

)

# 次元を元に戻して返す

return (

q_rot.view(B, H, S, D),

k_rot.view(B, H, S, D),

)

実際の運用

sin/cos のキャッシュ

最大長で 1 回作って slice するのが一般的。

cos = cos[:current_seq_len]

sin = sin[:current_seq_len]

sin/cos を static buffer として register_buffer 化。

2D RoPE

軸の周波数

1D トークン位置 $n$ を 2D のトークン位置 $\mathbf{p}_n = (p_n^x, p_n^y) \; \mathrm{where}\; p_n^x \in \{ 0, 1, ..., W \}, p_n^x \in \{ 0, 1, ..., H \}$ に変換する:

\[ \large{ \begin{split} &\mathbf{R}(n, 2t) &= e^{i\theta_t p_n^x}\\ &\mathbf{R}(n, 2t+1) &= e^{i\theta_t p_n^y} \end{split} } \]なお $(p_n^x, p_n^y)$ の位置インデックスの範囲は平方根で削減される。周波数 $\theta_t$ も同様に:

\[ \large{ \theta_t = 100^{-t/(d_{\mathrm{head}}/4)}, \; \mathrm{where} \; t \in \{ 0, 1, ..., d_{\mathrm{head}}/4 \} } \]学習可能な周波数のミックス

軸で RoPE を拡張するのは単純で効率的だが、対角方向の成分を処理できない。これは画像処理モデルの性能を低下させる可能性がある。

対角成分も処理できるようにするには、回転行列を以下のように定義する:

\[ \large{ \mathbf{R}(n, t) = e^{i(\theta_t^x p_n^x + \theta_t^y p_n^y)} } \]RoPE アテンション行列は以下のようになる:

\[ \large{ \mathrm{A}^\prime_{(n,m)} = \mathrm{Re}\left[ \mathbf{q}_n \mathbf{k}_m^* e^{i(\theta_t^x (p_n^x - p_m^x) + \theta_t^y (p_n^y - p_m^y))} \right] } \]LLM では RoPE と軸の周波数は固定値だったが、画像処理モデルでは $(\theta_t^x, \theta_t^y)$ を学習可能にする。

最小構成の 2D RoPE の実装

import torch

def apply_2d_rope(q, k, base=10000.0):

# q, k: [B, H, W, D]

B, H, W, D = q.shape

assert D % 4 == 0

Dh = D // 2

P = Dh // 2 # number of rotary pairs per axis

device, dtype = q.device, q.dtype

inv_freq = 1.0 / (base ** (torch.arange(P, device=device, dtype=dtype) / P))

y = torch.arange(H, device=device, dtype=dtype)[:, None] # y.shape = [H, 1]

x = torch.arange(W, device=device, dtype=dtype)[:, None]

cos_y, sin_y = torch.cos(y * inv_freq), torch.sin(y * inv_freq)

cos_x, sin_x = torch.cos(x * inv_freq), torch.sin(x * inv_freq)

def rotate(t, cos, sin):

t = t.view(B, H, W, P, 2)

t0, t1 = t[..., 0], t[..., 1]

return torch.stack([t0 * cos - t1 * sin,

t0 * sin + t1 * cos], dim=-1).view(B, H, W, -1)

qy, qx = q.split(Dh, dim=-1)

ky, kx = k.split(Dh, dim=-1)

q = torch.cat([rotate(qy, cos_y[:, None], sin_y[:, None]),

rotate(qx, cos_x[None, :], sin_x[None, :])], dim=-1)

k = torch.cat([rotate(ky, cos_y[:, None], sin_y[:, None]),

rotate(kx, cos_x[None, :], sin_x[None, :])], dim=-1)

return q, k

mRoPE・3D Unified RoPE(Qwen2-VL: Enhancing Vision-Language Model's Perception of the World at Any Resolution)

Lumina-Image 2.0 や Z Image Turbo で使われている。

Z Image Edit では入力画像と潜在ノイズとの RoPE の x と y とを一致させ、時間次元だけ変更している。

\[ \large{ \begin{split} \mathbf{R}(n, t) &= e^{i(\theta_t^x p_n^x + \theta_t^y p_n^y + \theta_t^{\mathrm{time}} \mathrm{time}_n)} \\ \mathrm{A}^\prime_{(n,m)} &= \mathrm{Re}\left[ \mathbf{q}_n \mathbf{k}_m^* e^{i(\theta_t^x (p_n^x - p_m^x) + \theta_t^y (p_n^y - p_m^y) + \theta_t^{\mathrm{time}} (\mathrm{time}_n - \mathrm{time}_m))} \right] \end{split} } \]MSRoPE

Column-wise Position Encoding は画像と結合されたプロンプトの座標の x 座標のみを増加させていた。しかし、これは画像が横に続いているのかプロンプトなのかが判別できない。そこで MSRoPE ではプロンプト座標の x, y 両方の座標を増加させ、画像とプロンプトの区別をしやすくした。

Mix-FFN

3x3 の畳み込みによって RoPE なしでも相対位置情報を取得できる。SegFormer の Mix-FFN は以下のようになる。

\[ x_{out} = \mathrm{MLP}(\mathrm{GELU}(\mathrm{Conv}_{3\times 3}(\mathrm{MLP}(x_{in})))) + x_{in} \]SANA の Mix-FFN は GELU ではなく SiLU を使っている。SiLU(Swish) は ReLU に形が似ていて、(0, 0) を通る。0を境界に導関数が急に変化する ReLU と違い、SiLU は導関数が滑らかに変化する。

GELU も SiLU も ReLU のような形で導関数が滑らかに変化するように設計されたもの。GELU の方が性能が良いが、SiLU の方が計算が速く、どちらも ReLU より性能が良い。

SANA が Mix-FFN を使用しているが、その隠れ層の次元が 5,600 もあり、RoPE を使った方が速い可能性が高い。

外部リンク

SANA は RoPE ではなく Mix-FFN を採用している。

RoFormer: Enhanced Transformer with Rotary Position Embedding

Rotary Position Embedding for Vision Transformer

目的関数

ノイズを予測させる epsilon prediction から、ノイズ差分を予測させる v parameterization へトレンドが移り、2025 年では Rectified Flow や Flow matching を使うのが一般的になっている。

シンプルなまとめとしては Diffusion Meets Flow Matching: Two Sides of the Same Coin が参考になる。

将来有望な技術

- Energy-Based Transformers

- Energy-Based Learning については A Tutorial on Energy-Based Learning. Yann LeCun et al. 2006(pdf)を参照

- Transition Matching

- Pixel Neural Field Diffusion

- Network of Theseus (like the ship)。表現を学習させることでモデルのパーツを入れ替える(CNN -> MLP, Transformer -> RNN/Patch-MLP など)。驚くべきことに教師モデルは未学習でも構造を転移可能

- The Neural Differential Manifold: An Architecture with Explicit Geometric Structure ニューラルネットを微分可能多様体として再構築する。各レイヤーは局所座標系(local coordinate chart)として機能する。ネットワークパラメーターは各点でのリーマン計量テンソルを直接パラメータ化する。この手法は性能が向上するのではなく、ネットワークの解釈可能性を大幅に改善する。

- 誤差逆伝播法を使用しない並列学習

v parameterization と Rectified Flow は何が違うか

記号の定義

- $\mathbf{\epsilon}$ ノイズ

- $\mathbf{x}_0$ 教師画像

- $\alpha_t$ ノイズのウェイト

- $\sigma_t$ 教師画像のウェイト

| v-parameterization | Rectified Flow | |

| 予測対象 | $\mathbf{v}_t = \alpha_t \mathbf{\epsilon} - \sigma_t \mathbf{x}_0$ | $\mathbf{v}_t = \mathbf{\epsilon} - \mathbf{x}_0$ |

| 損失関数 | $\mathcal{L} = ||\hat{\mathbf{v}} (\mathbf{x}_t, t) - \mathbf{v}_t||^2$ | $\mathcal{L}_{RF} = ||\hat{\mathbf{v}} (\mathbf{x}_t, t) - \mathbf{v}_t||^2$ |

| 設計目的 | ノイズとデータ両方を学習する | サンプリング経路を直線化し 学習と推論を簡素化する |

$\mathbf{v}_t = \mathbf{\epsilon} - \mathbf{x}_0$ より、Rectified Flow は $\mathbf{v}_t$ の速度が時刻 t に依存せずに一定である、というところが v-parameterization と違う。

v-parameterization は従来の拡散モデルの枠組みの中での損失関数の工夫。Rectified Flow は forward/backward プロセス自体を変更し、それに伴って損失関数も簡素化された。

$\alpha_t = \sigma_t$ ならば v-parameterization と Rectified Flow は同じものになるが、通常は $\alpha_t \ne \sigma_t$。

フローベースモデルの変遷

DDPM / Score-based model

拡散モデルは以下のような確率フロー(SDE)に基づく生成モデル:

\[ d\mathbf{x}_t = f(\mathbf{x}_t, t)dt + g(t) d\mathbf{w}_t \]その生成過程は Probability Flow ODE によって以下のような決定論的フローへ落とし込める:

\[ \dfrac{d\mathbf{x}_t}{dt} = f(\mathbf{x}_t, t) + \dfrac{1}{2}g(t)^2 \nabla_x \mathrm{log}\; p_t(\mathbf{x}) \]この事実が、「そもそも 密度の時間発展を直接 ODE で学習できるのでは?」という流れを生み、フローベース生成モデルの再興につながる。

Continuous Normalizing Flow(CNF)

CNF は連続時間 ODE による可逆変換で分布を輸送するモデル。

\[ \dfrac{d\mathbf{x}_t}{dt} = \mathbf{v}_\theta (\mathbf{x}_t, t), t \in [0, 1] \]初期分布 $p_0(\mathbf{x})$ (たとえば標準正規分布)からデータ分布 $p_1(\mathbf{x})$ へ写像する。

対数尤度をとると:

\[ \begin{split} \dfrac{d}{dt}\mathrm{log}\; p_t(\mathbf{x}_t) &= -\mathrm{div}_{\mathbf{x}} \mathbf{v}_\theta (\mathbf{x}_t, t) \\ \mathrm{log} \; p_1(\mathbf{x}_1) &= \mathrm{log}\; p_0(\mathbf{x}_0) - \int_0^1 \mathrm{div} \mathbf{v}_\theta(\mathbf{x}_t, t) dt \end{split} \]しかし CNF は以下の問題がある:

- divergence 計算が高コスト(画像では致命的)

- MLE 学習が不安定

- 拡散モデルのようなロバスト性がない

なので密度を使わず、流れそのものを直接学習するようになった。

Flow Matching

CNF は密度 $p_t$ を直接扱うため計算が現実的ではなかった。Flow Matching は「中間分布を定義し、そこに対応する真の速度場を教師として回帰する」という発想でこれを回避する。

- $\mathbf{x}_0 \sim p_0$:ノイズ分布

- $\mathbf{x}_1 \sim p_1$:データ分布

に対し、補間分布 $p_t$ を以下のように定義する:

\[ \mathbf{x}_t = (1-t)\mathbf{x}_0 + t\mathbf{x}_1 = \sigma (t)\epsilon \]このときの真の条件付き速度場は:

\[ \mathbf{v}^*(\mathbf{x}_t, t) = \mathbb{E}\left [ \dfrac{d\mathbf{x}_t}{dt} \middle | \mathbf{x}_t\right ] \]Flow Matching 損失は:

\[ \mathcal{L}_{\mathrm{FM}} = \mathbb{E}_{t,\mathbf{x}_t} \left [ || \mathbf{v}_\theta (\mathbf{x}_t,t) - \mathbf{v}^*(\mathbf{x}_t, t) ||^2 \right ] \]Flow Matching は以下の特徴がある。

- スコア $\nabla \mathrm{log} \; p_t$ 不要

- divergence の計算が不要

- ODE サンプリング可能

- ガウシアン補間を使うと Probability Flow ODE と一致し、『Flow Matching は「拡散モデルを密度なしで再定式化したもの」』と解釈可能

Rectified Flow

Flow Matching は速度場が曲がりやすく以下の問題がある。

- ODE 積分誤差が大きい

- ステップ数削減に限界がある

Rectified Flow は「最短経路(直線)に近い流れを学習させる」ことを目的とする。

定義:

\[ \mathbf{x}_t = (1-t)\mathbf{x}_0 + t\mathbf{x}_1 \]このときの真の速度は以下の定数になる:

\[ \dfrac{d\mathbf{x}_t}{dt} = \mathbf{x}_1 - \mathbf{x}_0 \]損失は:

\[ \mathcal{L}_{\mathrm{RF}} = \mathbb{E} \left [ || \mathbf{v}_\theta (\mathbf{x}_t,t) - \mathbf{x}_1 - \mathbf{x}_0 ||^2 \right ] \]Towards Hierarchical Rectified Flow

Rectified Flow はモデルに平均速度を予測させるが、Hierarchical Rectified Flow は加速度を予測させる。CIFAR-10 と ImageNet-32 のデータセットを使った検証では Rectified Flow より収束が速い。

Hierarchical Rectified Flow Matching with Mini-Batch Couplings では Data & Velocity Coupling で1ステップでもそこそこの品質の画像を生成している。

x pred の方が高性能かもしれない

Tianhong Li と Kaiming He は Back to Basics: Let Denoising Generative Models Denoise でノイズを予測する ε pred や「画像 - ノイズ」を予測する v parameterization より画像を直接予測する x pred が性能がよい可能性を指摘した。

多様体仮説*1によれば、画像は高次元のピクセル空間内の低次元の多様体内に存在している。ノイズのない画像は多様体としてモデリング可能だが、ノイズや速度は多様体外にある。なので、ノイズのない画像を直接予測するモデルとノイズや速度を予測するモデルとは根本的に異なる。

論文ではトークナイザ(VAE)なし、事前学習なし、追加損失(LPIPS や GAN)なしで、巨大パッチサイズ(16 と 32。通常は 2)で拡散トランスフォーマーを x pred で学習させている。

ネットワークは画像を直接予測させるが、損失は速度を使うと性能が上がる。

解像度に合わせてパッチサイズを増やすことで、演算負荷をそれほど増やさずに性能をスケールさせられることを実証している。

ネットワークの最初の線形パッチブロックの次元を削減すると性能が上がると報告している。

*1: livier Chapelle, Bernhard Sch¨olkopf, and Alexander Zien, editors. Semi-Supervised Learning. MIT Press, Cambridge, MA, USA, 2006.

数式

ノイズを $\epsilon \sim \mathcal{N}(0, \mathbf{I})$、ノイズの乗ったサンプル $z_t = a_t x + b_t \epsilon, \mathrm{where} \;a_t, b_t \in [0, 1]$ とすると:

\[ z_t = t x_\theta + (1-t)\epsilon_\theta \]$\epsilon_\theta$ は $\epsilon$ pred を考えるときに必要になるが、x pred や v pred の場合は $\epsilon$ とする。

$z_t$ を t で微分すると以下の速度が得られる:

\[ v_\theta = x_\theta - \epsilon_\theta \]上記の3つの式をまとめると:

\[ \large{ \begin{split} x_\theta &= \mathrm{net}_\theta (z_t, t)\\ z_t &= t x_\theta + (1-t)\epsilon_\theta \\ v_\theta &= x_\theta - \epsilon_\theta \end{split} } \]モデルが x pred $\mathbf{x}_\theta := \mathrm{net}_\theta (z_t,t)$ とすると、その v-loss は:

\[ \large{ \begin{split} \mathcal{L}_{v}&= \mathbb{E}||v_\theta - v||^2\\ v_\theta &= (x_\theta - z_t)/(1-t) \end{split} } \]# net(z, t): JiT network

# x: training batch

import torch

import torch.nn as nn

t = sample_t()

e = randn_like(x)

z = t * x + (1 - t) * e

v = (x - z) / (1 - t)

x_pred = net(z, t)

v_pred = (x_pred - z) / (1 - t)

loss = nn.MSELoss(v - v_pred) # L2 loss

パッチ

論文では固定解像度なので Linear でパッチ化しているが、可変解像度の場合は畳み込みを使う。

単段 CNN の実装。表現能力を Transformer に丸投げする設計で、Transformer が余計な表現も学習する必要がある(解像度が変わると トークン統計が大きく変動)ので、性能が低下する。

class PatchEmbed(nn.Module):

def __init__(self, patch=16, dim=768):

super().__init__()

self.proj = nn.Conv2d(3, dim, patch, stride=patch)

def forward(self, x):

# x.shape = [B, 3, H, W]

x = self.proj(x) # [B, dim, H/patch, W/patch]

# 位置埋め込みをする場合はここで行う

x = x.flatten(2).transpose(1, 2)

return x # [B, (H/patch)*(W/patch), dim]

多段 CNN の実装。事実上のデファクト。視覚表現を構造的に整形してから Transformer に渡す設計。

class PatchEmbed(nn.Module):

def __init__(self, patch=4, dim=768):

super().__init__()

self.cnn1 = nn.Conv2d(3, 3, patch, stride=patch)

self.cnn2 = nn.Conv2d(3, 3, patch, stride=patch)

self.cnn3 = nn.Conv2d(3, dim, 1, 1)

def forward(self, x):

# x.shape = [B, 3, H, W]

x = self.cnn1(x) # [B, 3, H/patch, W/patch]

x = self.cnn2(x) # [B, 3, H/(patch^2), W/(patch^2)]

x = self.cnn3(x) # [B, dim, H/(patch^2), W/(patch^2)]

x = x.flatten(2).transpose(1, 2) # [B, (H/patch)*(W/patch), dim]

return x

参考文献

Improving and generalizing flow-based generative models with minibatch optimal transport

Flow Straight and Fast: Learning to Generate and Transfer Data with Rectified Flow

SiT: Exploring Flow and Diffusion-based Generative Models with Scalable Interpolant Transformers

Transition Matching: Scalable and Flexible Generative Modeling

Transformer アーキテクチャ

U-Net より Transformer が選択されるのは、モデルサイズを大きくしたときの性能のスケール率が大きいため(Transformer の方が巨大モデルのパラメータ効率がよい)。

Transformer のトレンドは以下のように変化した

- sinusoidal positional embedding -> RoPE

- Multi-Head Attention

- GELU -> SwiGLU

- LayerNorm -> RMSNorm

- QK-Norm

- Mixture-of-Experts

- Mixture-of-Recursions

Grouped-Query Attention

Grouped-Query Attention は Multi-Head Attention の K, V を複数のクエリで共有する。 GQA-4 のケースでは、K と V との数が 1/4 になり、推論速度が 1.3 倍高速になり、メモリ使用量 50% 減少、性能の低下は1~3%。

Dit-Air ではヘッドだけではなく、QKVO をすべてのトランスフォーマーブロックで共有している。

スパースアテンション

スパースアテンションの比較は The Sparse Frontier: Sparse Attention Trade-offs in Transformer LLMs を参照。

スパースアテンションはトークン数が少ない場合は効果が薄い。さらに「汎用スパース化」は存在せず、タスク・モデル・長さの組み合わせごとのスパース化手法の詳細評価が必須。

QK 行列を LoRA 化して計算を近似する Low-Rank Approximation for Sparse Attention in Multi-Modal LLMs がある。

Deepseek Sparse Attention はアテンションに MoE のような構造を導入しアテンションのコストを削減した。

Trainable Log-linear Sparse Attention for Efficient Diffusion Transformers ではスパースアテンションを階層化してさらにコスト削減。

Gated Attention

Gated Attention for Large Language Models: Non-linearity, Sparsity, and Attention-Sink-Free は SDPA の後にシグモイドを入れるだけで性能を向上させた。

Multi-Head Latent Attention

DeepSeek-V2 で採用された、KV キャッシュを圧縮する手法。

QK-Norm

Multi-Head Attention の Q, K の RoPE 適用前に RMSNorm を入れる。

SwiGLU

ゲートの活性化関数に Swish を使ったもの。SwiGLU は入力の二乗や乗算のような多項式近似をエミュレートできるのが強み。LLM では事実上のスタンダードになっている。表現力の向上、収束の高速化(学習の高速化)、大規模モデルでの性能向上が見られることが複数の論文で実証されているが、性能向上の理由は不明。

従来の FFN は2つの重み行列(W1, W2)を持つのに対し、GLU 派生は3つ(W, V, W2)持つ。なので SwiGLU を含む GLU の派生形のパラメータ数は、FFN と比較して、隠れ層の次元が 2/3 に削減される。

SwiGLU は外れ値同士が掛け算されて値が増幅されることがある。Smooth-SwiGLU によってその問題は解決され、LLM では FP8 での学習も可能になっている。

ReLUと比較して、SwiGLUは固有のスパース性がほとんどないため、従来のスパース性を活用する技術の効果が薄い。

DiT においては収束を 21 倍加速させた事例が報告されているが、性能が向上した論文はない。

参考文献

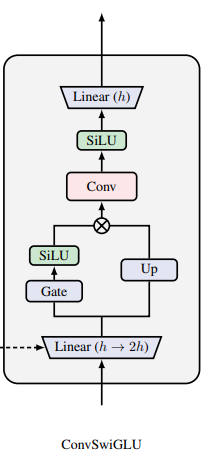

ConvSwiGLU

ConvSwiGLU は推論モデルで性能向上が確認されている。

入力シーケンス $X \in \mathbb{R}^{T \times d}$ の潜在次元を拡張したあと、Gate + SiLU と Conv +SiLU を通る:

\[ \large{ \begin{split} [\mathbf{G, U}] &= XW_{\mathrm{up}} \in \mathbb{R}^{T \times 2m}\\ \mathbf{H}_{\mathrm{ffn}} &= \mathrm{SiLU(\mathbf{G}) \odot \mathbf{U}} \\ \mathbf{H}_{\mathrm{conv}} &= \sigma (\mathbf{W}_{\mathrm{dwconv}} * \mathbf{H}_{\mathrm{ffn}})\\ \mathbf{Y}_{\mathrm{ConvSwiGLU}} &= [ \sigma (\mathbf{W}_{\mathrm{dwconv}} * ( \mathrm{SiLU(\mathbf{G}) \odot \mathbf{U}})) ]W_{\mathrm{down}} \end{split} } \]参考文献

The Big LLM Architecture Comparison

シングルストリーム vs デュアルストリーム

デュアルストリームは画像パッチとテキストとで別々の FFN を通過させる。シングルストリームは FFN を分離しない。

デュアルストリームを採用することが多いのは、画像とテキストとのトークン数の違いからくる。例えば、VAE が F8P2 で、画像の解像度が 1024 だとする。すると画像のトークン数は (1024/(8*2))^2 = 4,096 トークン。これにたいしてテキストのトークン数が 1,000 を超えることはまずない。

このような状況なので、シングルストリームでは FFN は、テキストを無視して画像トークンに FFN を最適化するようになる。なのでテキストの追従性を高めるためにデュアルストリームが主流になっている。

Linear Attention

Linear Attention は KV 行列を先に計算することで、トークン数に依存せずに定数時間で計算できるが、性能は低下する。

The Devil in Linear Transformer

- 無限大に発散する勾配:Linear Attention はスケーリングが不要にもかかわらず Attention 行列に過度なスケーリングが入り込み,勾配が発散し収束を阻害する

- 注意の希薄化(Attention Dilution):長い系列に対して Attention weight が一様に分散され、隣接構造への Attention が失われる

FLatten Transformer: Vision Transformer using Focused Linear Attention

Linear Attentionの性能劣化要因として、フォーカス能力の不足・特徴多様性の欠如(ランク制限)を分析し、マッピング関数とランク復元モジュールによって表現力を高める手法を提案。複数のビジョンタスクで一貫して性能向上を確認している。

Breaking the Low-Rank Dilemma of Linear Attention

Linear Attention の出力特徴マップ(KV バッファ)が Softmax Attention に比べて低ランクとなり、表現力を制限する。これらを解消する Rank-Augmented Linear Attention (RALA) を提案し,ImageNet性能でSoftmaxに迫る改善を示している。

Bridging the Divide: Reconsidering Softmax and Linear Attention

理論的観点からLinear Attentionが満たさない2つの性質を指摘している。

- 注入性(Injectivity)の欠如:異なるクエリに同一の Attention weight が割り当てられ、意味的混乱を招く

- 局所モデル化能力の不足:Softmax のように近傍構造を重視できず、視覚タスクでの性能に差が出る

これらを付与すると Linear Attention が Softmax を上回る可能性を示唆している。

DeltaNet Explained

Linear Attention を連想メモリとみなした場合、消去機構がなく既存情報が蓄積し続けるため、長系列で "検索誤差" が蓄積し性能低下を招くと解説。これは固定サイズの状態行列に新しい key–value だけを追加し続ける構造的制約によるもの。

Rectifying Magnitude Neglect in Linear Attention

Softmax Attention ではクエリベクトルの大きさが注意分布に影響を与えるが、Linear Attentionではカーネル変換後の大きさ成分が相殺され、方向情報のみで注意を計算するため適応性を欠く。Magnitude-Aware Linear Attention (MALA) を提案し、大きさ情報を再導入する改善を示している。

Transformer を使わないアーキテクチャ

計算ボトルネックである Attention を削減できるので、パラメータ数と計算にかかるコストを同時に削減できる。

しかしこれらのアーキテクチャは解像度が固定なので生成 AI では使えない。

結局のところ可変解像度に対応するには、位置エンコーディングに加え、畳み込みか Attention かを使うしかない。

Gated MLP

Pay Attention to MLPs では Attention を Gate で置き換えて、Transformerに匹敵する性能を達成できることを示した。

MLP-Mixer

注意機構と畳み込みを完全に排除した純粋なMLPアーキテクチャ。

- Token-mixing MLP:パッチ間の空間的情報を混合

- Channel-mixing MLP:チャンネル次元の特徴を混合

- 線形スケーリング:注意機構のO(N2)から改善

ResMLP

MLP-Mixer 同様、純粋にMLPのみで構成された残差ネットワーク。同等の計算量で MLP-Mixer を上回る。

S2-MLP: Spatial-Shift MLP Architecture for Vision

S2-MLP は空間シフト操作を導入してパッチ間通信を実現する。

- パラメータフリーシフト:隣接パッチへのチャンネルシフトで情報交換

- 局所受容野:隣接パッチのみとの直接的な情報交換

- 計算効率:Token-mixing MLPを完全に排除

S2-MLP は MLP-Mixer より高い精度を達成し、ViT と同等の性能を少ないパラメータで実現した。

ブロック図

トランスフォーマーブロックの内部に以下のパターンが2~3回出現するのが基本。

- AdaLN

- Attention・MLP ・FFN

- Scale

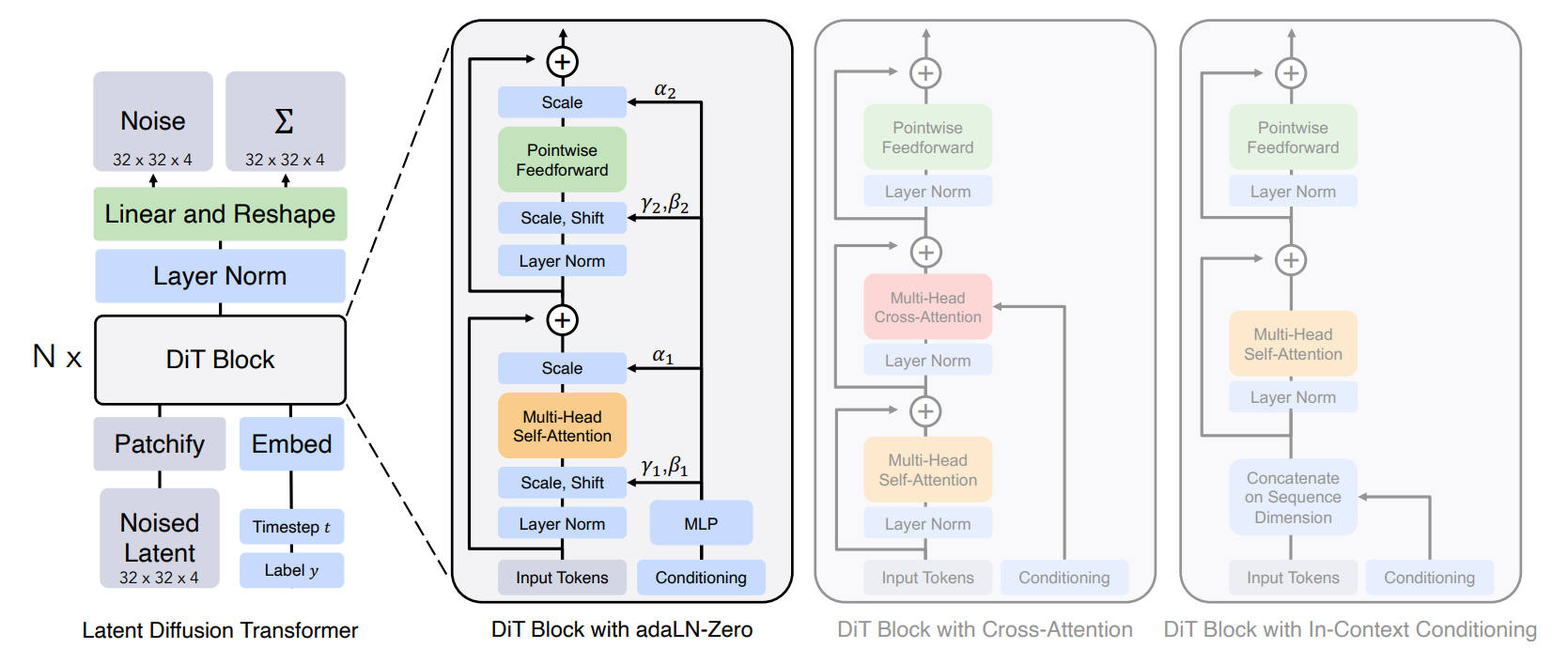

DiT

FFN

Pointwise Feedforward Network と Position-wise Feed-Forward Network とはほぼ同じ意味。バッチ・系列長・埋め込み次元のテンソルにおいて、各位置 i にあるベクトル x_i に対して、まったく同じ重みの MLP を適用する。数式は以下のようになる。

\[\mathrm{FFN}(x) = \mathrm{max}(0, xW_1 + b_1)W_2 + b_2\]Zero-Init. Gate(adaLN-Zero)

出典:Unveiling the Secret of AdaLN-Zero in Diffusion Transformer Jie Zhu et al. Figure. 2 https://openreview.net/forum?id=E4roJSM9RM

Unveiling the Secret of AdaLN-Zero in Diffusion Transformer はガウス分布で初期化するアイデアに問題があり論文がリジェクトされているが、adaLN-Zero の分析は参考になる。

Patching(Patchify)

Transformer はトークン数の2乗で計算量が増えるので、パッチ化によってトークン数をチャンネル数に変換することで計算負荷を下げられる。dmodel > C * P * P のときにこの戦略は機能する。

VAE の設定が F8C4P2 とする。元の画像が 3 x 1024 x 1024 だとする。その潜在空間表現は 4 x 128 x 128。パッチサイズが2ということは4ピクセル(2 x 2)を一つの埋め込み次元にするので、16 x 64 x 64。16 = チャンネル数 * パッチサイズ^2。幅と高さを1次元化して転置すると、最終的に 4096 x 16 になる。埋め込み次元は 16 になる。

その後で Linear によって任意の埋め込み次元数に拡張する。

from einops import rearrange

# x = [B, C, H, W] -> [B, H*W, C*P*P]

patches = rearrange(x, 'b c (h p) (w p) -> b (h w) (c p p)', p=self.patch_size)

# [B, H*W, C*P*P] -> [B, H*W, D_model]

hidden_states = self.projection(patches)

# [B, H*W, D_model] -> [B, H*W, C*P*P]

patches = self.reverse_proj(hidden_states)

rearrange(patches, 'b (h w) (c f1 f2) -> b c (h f1) (w f2)', f1=P, f2=P, h=int(H/P), w=int(W/P))

# 畳み込みの場合

image_to_patches = nn.Conv2d(input_channel, model_dim, kernel_size=(P, P), stride=P, bias=True)

patches = image_to_patches(x)

tokens = rearrange(patches, 'b c h w -> b (h w) c')

# unpatch

patches_to_image_deconv = nn.ConvTranspose2d(model_dim, input_channel, kernel_size=(P, P), stride=P, bias=True)

patches = rearrange(tokens, 'b (h w) c -> b c h w', h=int(H/P), w=int(W/P))

patches_to_image_deconv(patches)

2022年

出典:Scalable Diffusion Models with Transformers. William Peebles et al. Figure 3. https://arxiv.org/abs/2212.09748

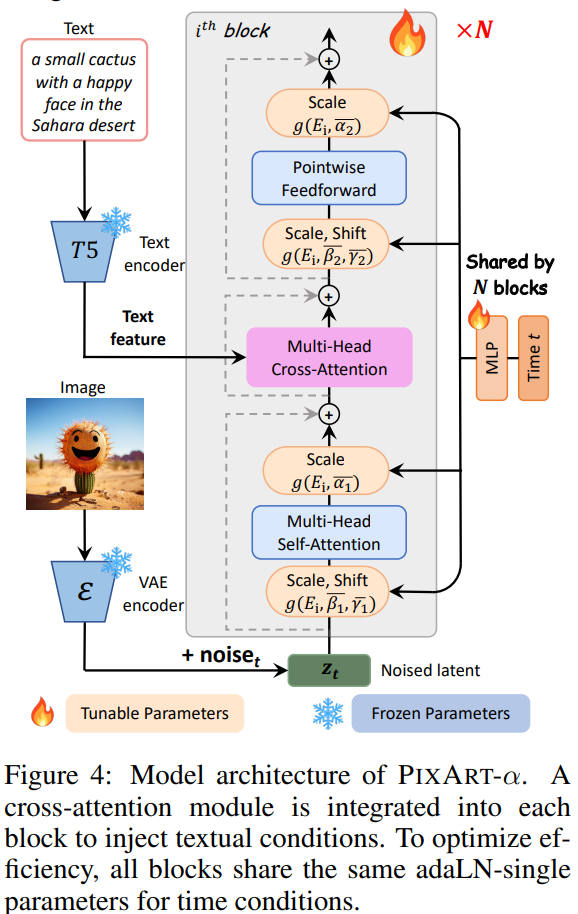

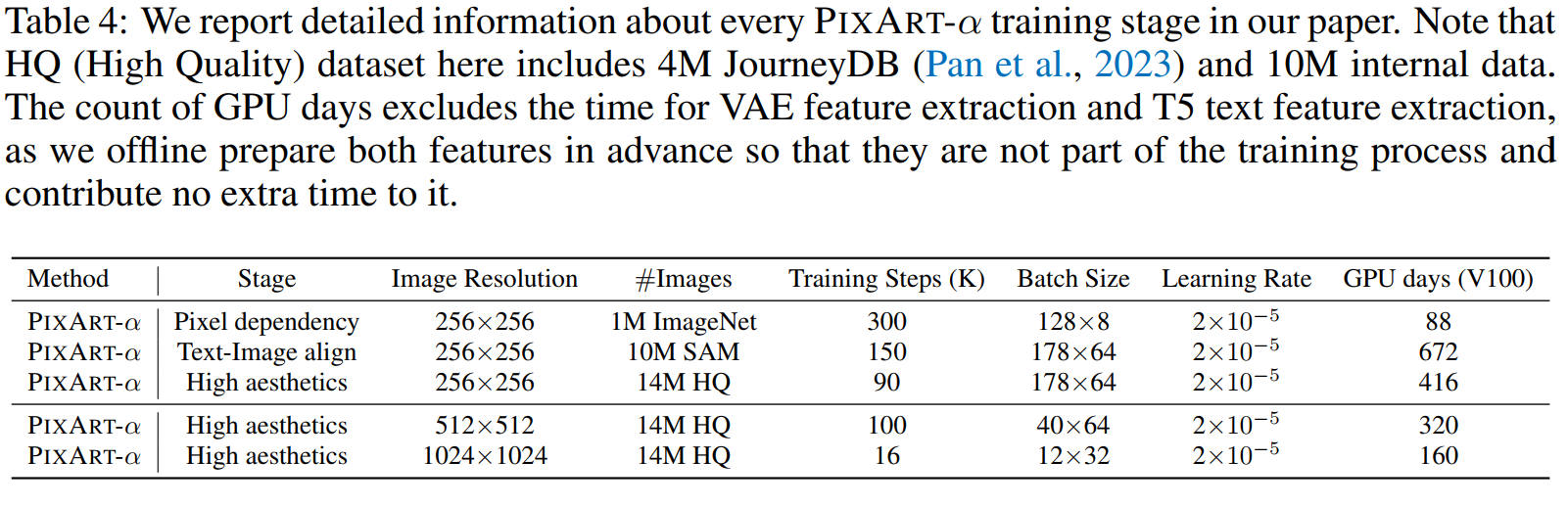

PixArt-α

位置エンコーディングには DiffFit: Unlocking Transferability of Large Diffusion Models via Simple Parameter-Efficient Fine-Tuning で使用された、 sinusoidal interpolation を使っている。実装は単純で、DiT の解像度は 256 だが DiffFit は 512 なので、DiT の sinusoidal encoding の (i, j) を (i/2, j/2) にしただけだ。

MLP

トランスフォーマーブロックの隠れ層と同じ次元を持つ、2レイヤーの MLP。活性化関数は SiLU。

2023年

出典:PixArt-α: Fast Training of Diffusion Transformer for Photorealistic Text-to-Image Synthesis. Junsong Chen et al. Figure 4. https://arxiv.org/abs/2310.00426

DiG: Scalable and Efficient Diffusion Models with Gated Linear Attention

2024 年。

Gated Linear Attention を採用し、DiG-S/2 モデルは標準の DiT-S/2 と比較して 2.5 倍高速であり、GPUメモリを75.7%節約できている。さらに FlashAttention-2 を使用した DiT よりも 2,048 解像度で 1.8 倍高速。

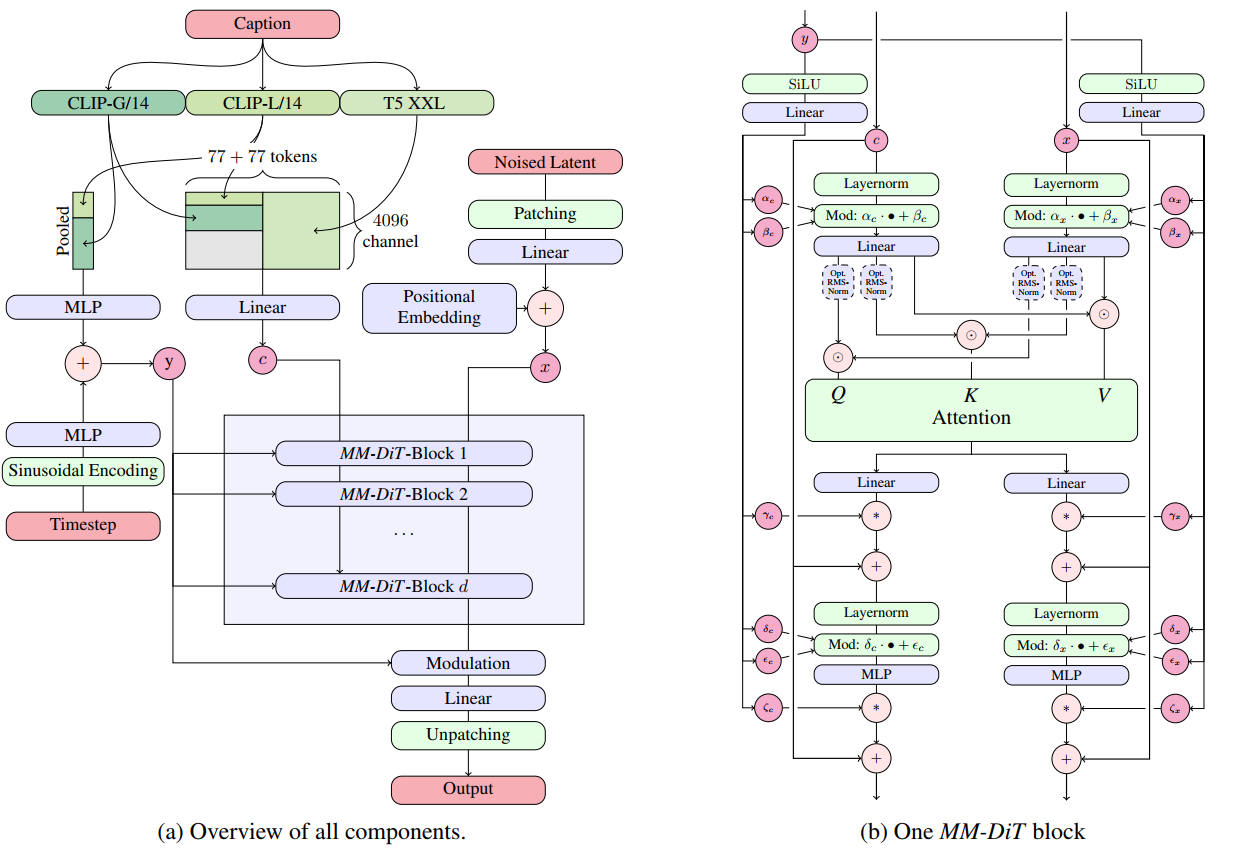

Stable Diffusion 3

テキストと画像とを別々に処理するダブルストリーム方式。

SD3 は設計が古いので RoPE を使わず、潜在ノイズをパッチ化した後に、潜在ノイズに位置埋め込みをしている。

Stable Diffusion 3(SD3)の理論やモデル構造について解説

2024年

出典:Scaling Rectified Flow Transformers for High-Resolution Image Synthesis. Patrick Esser et al. Figure 2. https://stability.ai/news/stable-diffusion-3-research-paper

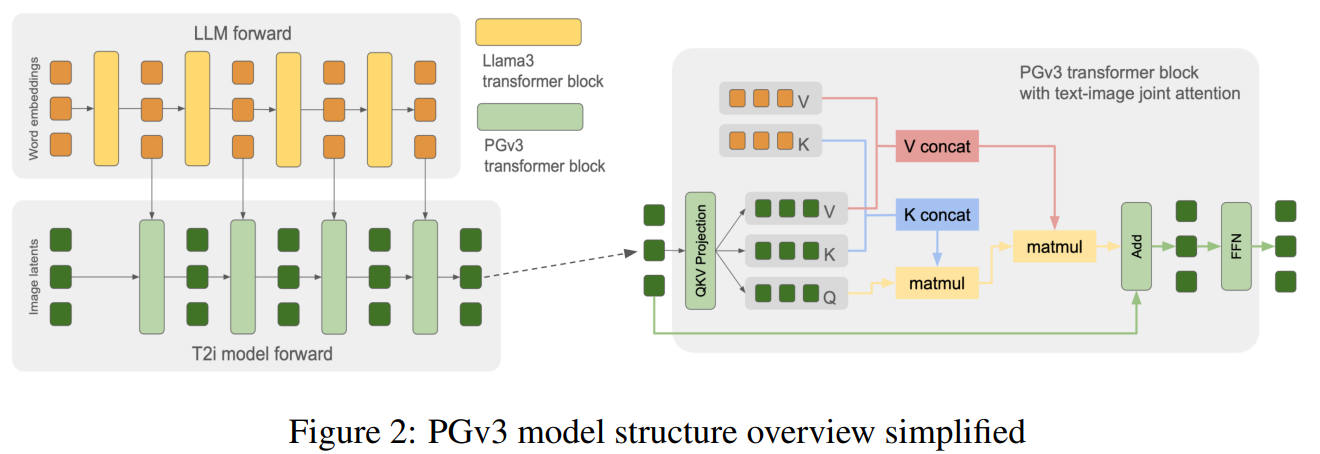

Playground v3

発表は 2024/09/16、設計の終了と学習の開始は Stable Diffusion 3(2024/02/22)の論文の発表前。

EDM スケジューラーを使っている。

2024年

出典:Playground v3: Improving Text-to-Image Alignment with Deep-Fusion Large Language Models. Bingchen Liu et al. Figure 2. https://arxiv.org/abs/2409.10695

FLUX.1

AuraFlow

Hunyuan-DiT

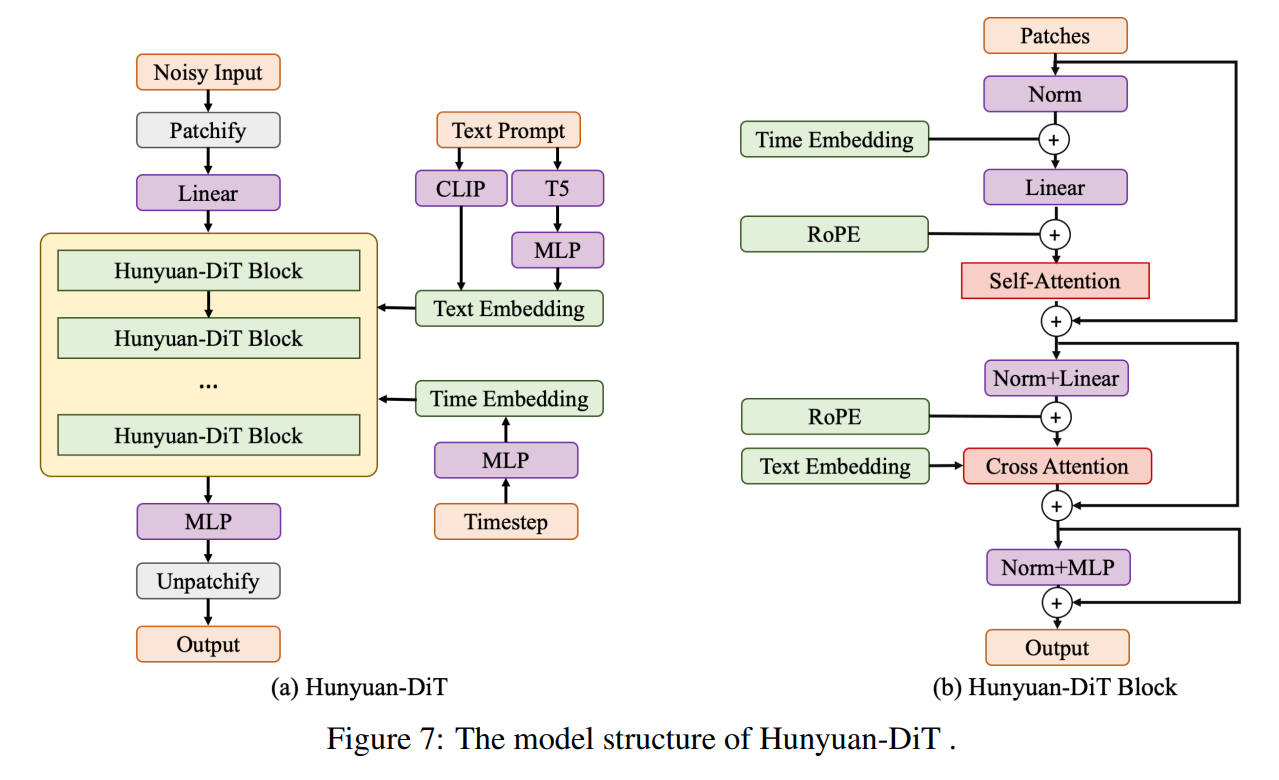

2024年

出典:Hunyuan-DiT: A Powerful Multi-Resolution Diffusion Transformer with Fine-Grained Chinese Understanding. Zhimin Li et al. Figure 7. https://arxiv.org/abs/2405.08748

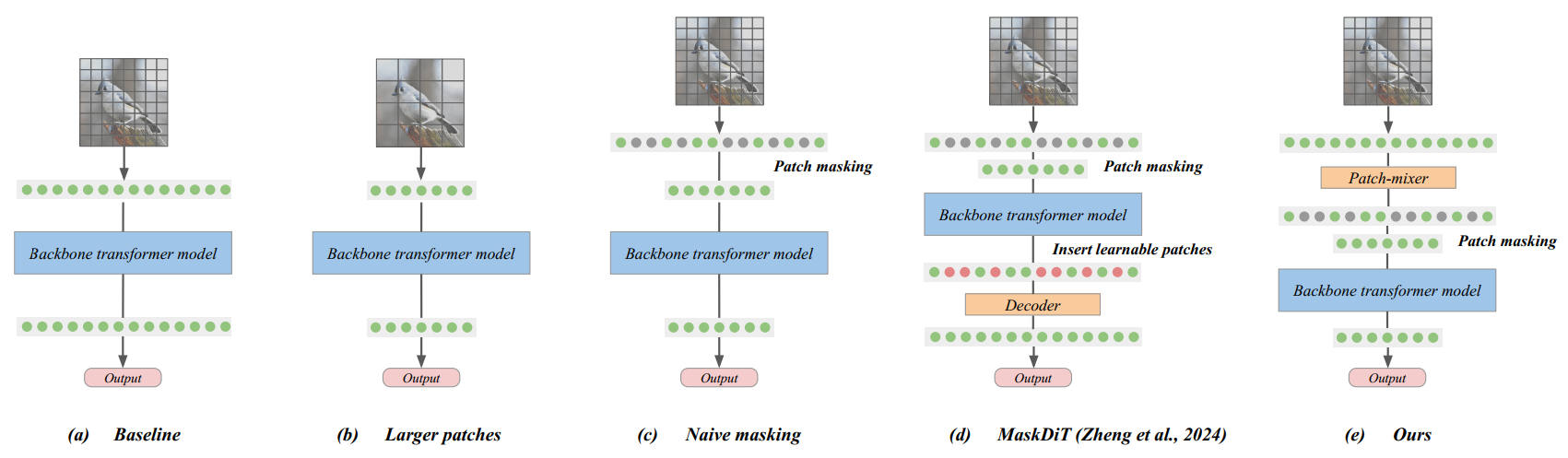

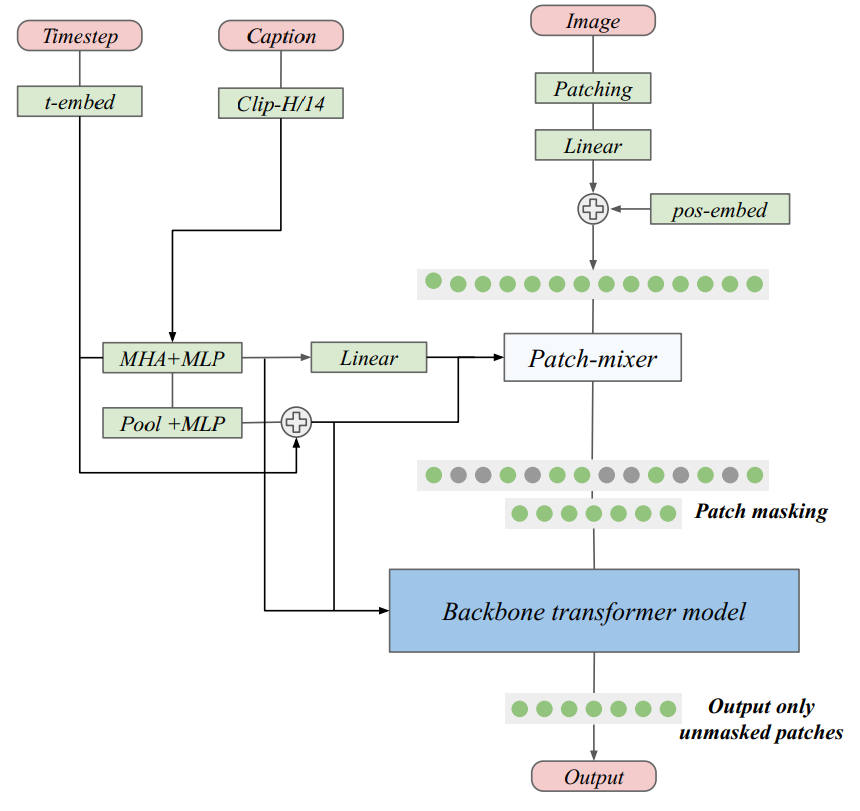

MicroDiT

パッチマスクはパッチのランダムドロップより性能が良いのでよく使われる(BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding, Masked Autoencoders Are Scalable Vision Learners)。Fast Training of Diffusion Models with Masked Transformers ではマスクパッチの再構成能力を上げるためにオートエンコーダー loss を利用している。これらの従来手法はパッチのマスク率が 50% を超えると性能が低下し始め、75% を超えると大幅に性能が低下する。しかし MicroDiT は 75% のマスク率でもわずかな性能低下に抑えられる。

MicroDiT はパッチマスクを行う前に Patch-mixer でテキスト Embedding を取り込むことで性能を向上させた。Patach-mixer はアテンションと FFN で構成された数レイヤーの Transformer。

2024年

出典:Stretching Each Dollar: Diffusion Training from Scratch on a Micro-Budget Vikash Sehwag et al. Figure 2. https://arxiv.org/abs/2407.15811

パッチマスクはブロックサイズを小さくしてランダムにした方が性能低下を抑えられる。

クロスアテンションでキャプションを取り込み、位置エンコーディングとタイムステップは Sinusoidal Embedding。

損失関数。マスクした部分は、元の画像+ノイズを予測させる。

\[ \begin{split} \mathcal{L}_{diff}&=\mathbb{E}_{(\mathbf{x},\mathbf{c})\sim\mathcal{D}}\mathbb{E}_{\mathbf{\epsilon}\sim\mathcal{N}(\mathbf{0},\sigma(t)^2\mathbf{I})}\left|\left|\big(\bar{F}_\theta((\mathbf{x}+\mathbf{\epsilon})\odot(1-m);\sigma,\mathbf{c})-\mathbf{x}\big)\odot(1-m)\right|\right|^2_2\\ \mathcal{L}_{mae}&=\mathbb{E}_{(\mathbf{x},\mathbf{c})\sim\mathcal{D}}\mathbb{E}_{\mathbf{\epsilon}\sim\mathcal{N}(\mathbf{0},\sigma(t)^2\mathbf{I})}\left|\left|\big(\bar{F}_\theta((\mathbf{x}+\mathbf{\epsilon})\odot(1-m);\sigma,\mathbf{c})-(\mathbf{x}+\mathbf{\epsilon})\big)\odot m\right|\right|^2_2\\ \mathcal{L} &= \mathcal{L}_{diff} + \gamma\mathcal{L}_{mae} \end{split} \]1.16B のモデルの学習に $1,890 のコストしかかかってない。

2024年

出典:Stretching Each Dollar: Diffusion Training from Scratch on a Micro-Budget Vikash Sehwag et al. Figure 3. https://arxiv.org/abs/2407.15811

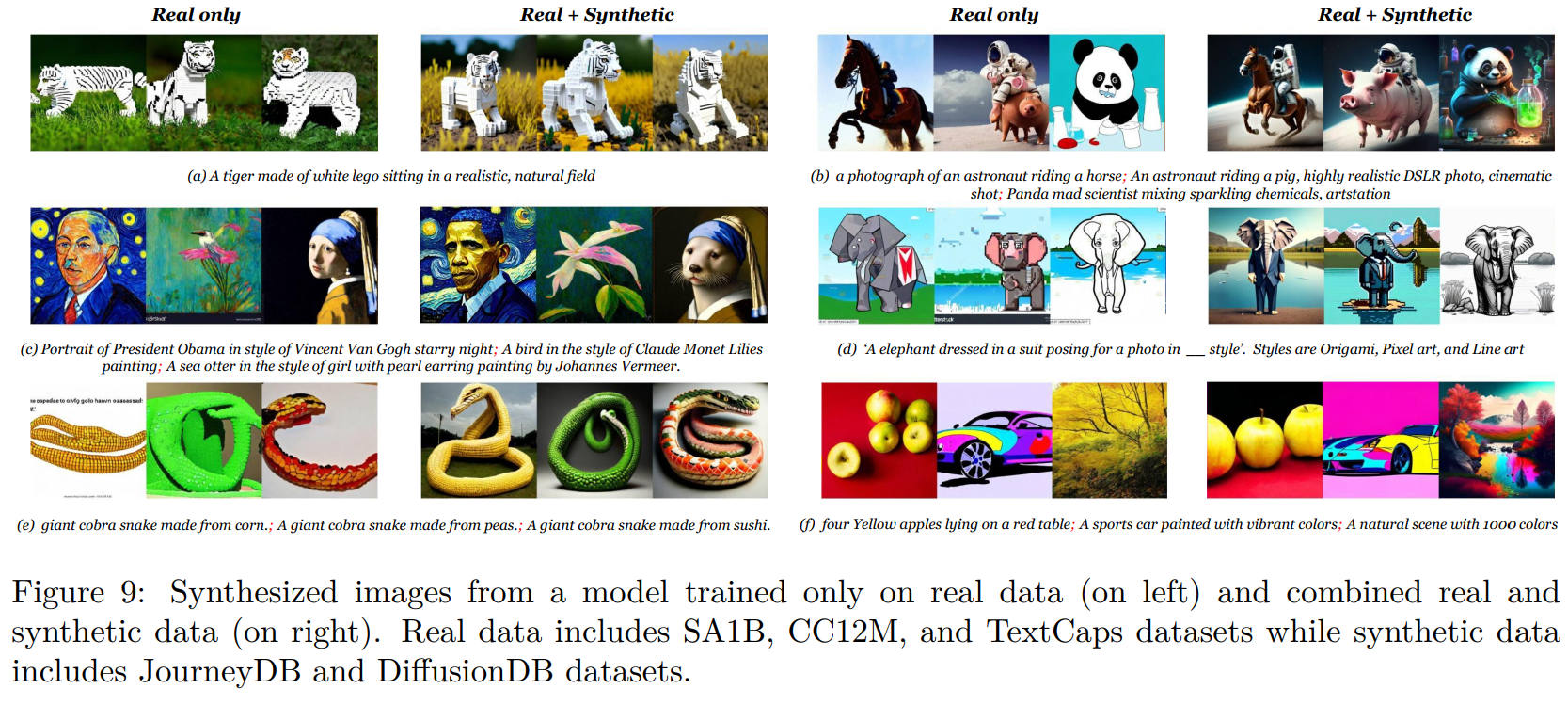

AI 生成画像を学習に使う

学習画像の 40% が JourneyDB や DiffusionDB の画像データ。これらの画像を使ってもベンチのスコアは変わらないが、主観的な品質は明らかに向上する。

そこで ChatGPT にどちらの画像が質が高いか質問した。プロンプトは「Which image do you prefer, Image A or Image B, considering factors like image details, quality, realism, and aesthetics? Respond with 'A' or 'B' or 'none' if neither is preferred.」DrawBench と PartiPrompts で生成したプロンプトで、AI 生成画像を学習に含めたものと含めなかったものとで画像を生成させて ChatGPT に評価させたところ、AI 生成画像を学習に含めたモデルの生成した画像が圧勝している。

出典:Stretching Each Dollar: Diffusion Training from Scratch on a Micro-Budget Vikash Sehwag et al. Figure 9. https://arxiv.org/abs/2407.15811

CLEAR

畳み込みのような演算でアテンションの計算コストを削減する。Linear Attention で計算コストを削減したのが SANA。

Lumina-Image 2.0

2025年

Element-wise Addition と Element-wise Multiplication は記号が逆

出典:Lumina-Image 2.0: A Unified and Efficient Image Generative Framework. Qi Qin et al. Figure 2. https://arxiv.org/abs/2503.21758

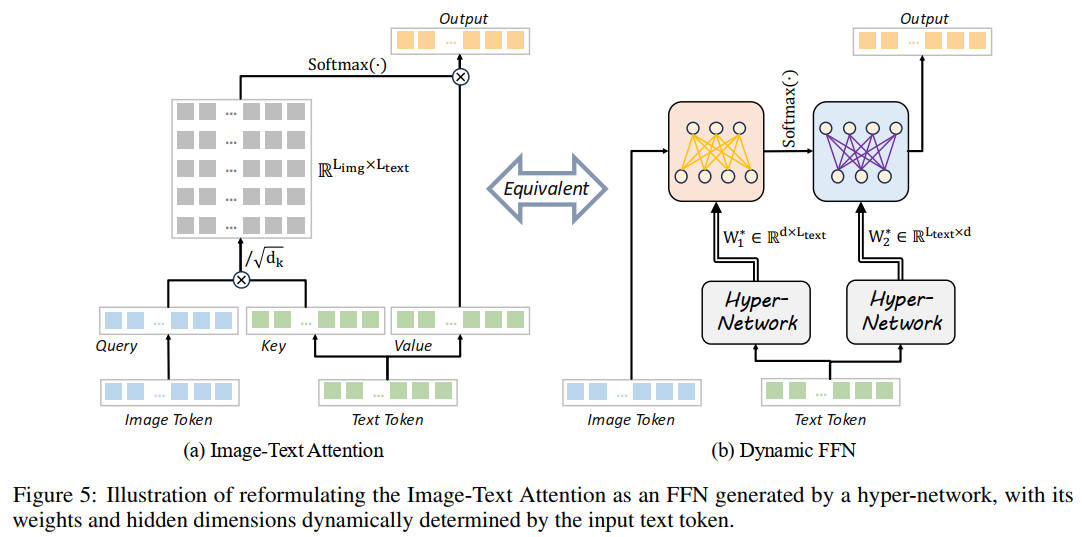

Image Text Attention は右の FFN と等価で、キャプションの量を増やせばネットワークのパラメータ数を増やすのと同じ効果がある

出典:Lumina-Image 2.0: A Unified and Efficient Image Generative Framework. Qi Qin et al. Figure 5. https://arxiv.org/abs/2503.21758

RMSNorm

RMSNorm は Layer Normalization の計算コストを削減したもの。具体的には各層の活性化に対して、平均の計算を省略し、二乗平均平方根 (Root Mean Square: RMS) のみを用いて正規化を行う。RMSNorm は LayerNorm と同等の性能を達成しつつ、計算時間を 7% 〜 64% 削減できる。

最新の pytorch には nn.RMSNorm があるので自分で実装する必要はない。

RMSNorm の実装例

class RMSNorm(torch.nn.Module):

def __init__(self, dim: int, eps: float=1e-5):

"""

基本的な役割はLayerNormと同じだが計算量が7%から64%少ない。ただし大規模なネットワークでは効果は小さい

Args:

dim (int): 入力次元

eps (float): 0 除算エラーを避けるバイアス

"""

super().__init__()

self.eps = eps

self.dim = dim

self.weight = nn.Parameter(torch.ones(dim))

self.bias = nn.Parameter(torch.zeros(dim))

def forward(self, x: torch.Tensor) -> torch.Tensor:

rms = torch.sqrt(torch.mean(x ** 2, dim=-1, keepdim=True)) + self.eps

x = x / rms

return self.weight * x + self.bias

ゲート

Gate は以下の式で表現される。ただし Normalization の後にゲートを入れる場合は、b1, b2 は、出力平均が0に近いため省略されることが多い。

\[ \displaylines{ \mathrm{Gate}(\mathbf{x}) = (\mathbf{x}W_1 + b_1) \odot \sigma(\mathbf{x}W_2 + b_2)\\ \begin{split} {\odot} &{: アダマール積(要素ごとの積)}\\ {\sigma} &{: 非線形活性化関数(\mathrm{sigmoid, GELU} など)} \end{split} } \]nn.Lienar は bias=False でバイアスを省略できる。

nn.Linear(in_features, out_features, bias=False) # バイアスなしGEGLU の実装例

import torch

import torch.nn as nn

import torch.nn.functional as F

class GEGLU(nn.Module):

def __init__(self, input_dim, hidden_dim):

super().__init__()

self.proj = nn.Linear(input_dim, hidden_dim * 2)

def forward(self, x):

x_proj = self.proj(x) # [B, T, 2*hidden_dim]

x1, x2 = x_proj.chunk(2, dim=-1) # 分割

return x1 * F.gelu(x2) # Gated

# 使用例

batch_size, seq_len, input_dim, hidden_dim = 32, 128, 512, 2048

x = torch.randn(batch_size, seq_len, input_dim)

geglu = GEGLU(input_dim, hidden_dim)

out = geglu(x) # -> [B, T, hidden_dim]

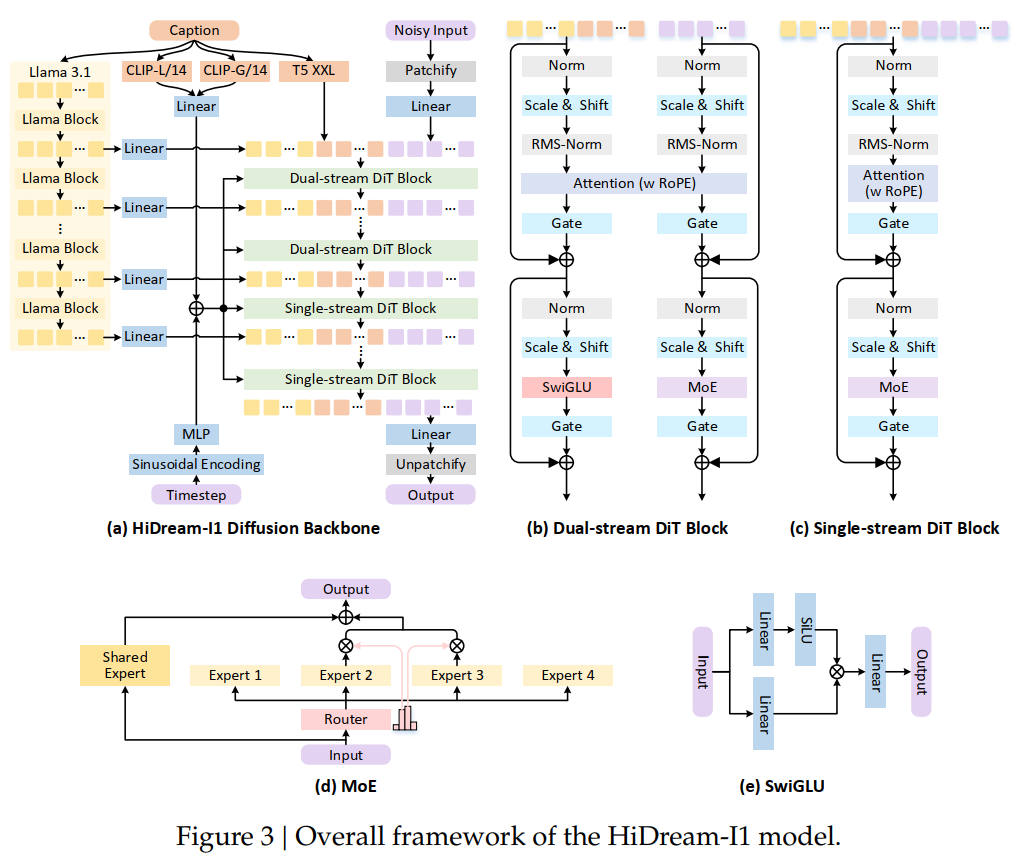

HiDream-I1

- パッチ使用

- Playground v3 のように LLM の中間出力を取り込んでいく

- FLUX.1 のようにデュアルストリームの後にシングルストリームになる

- SD3 と同じ3つのテキストエンコーダーに LLM を加え、合計4つのテキストエンコーダーを使用

- 位置エンコーディングは RoPE

- 拡散モデルでは珍しく MoE を採用している

2025年

出典:HiDream-I1: A High-Efficient Image Generative Foundation Model with Sparse Diffusion Transformer. Qi Cai et al. Figure 3. https://arxiv.org/abs/2505.22705

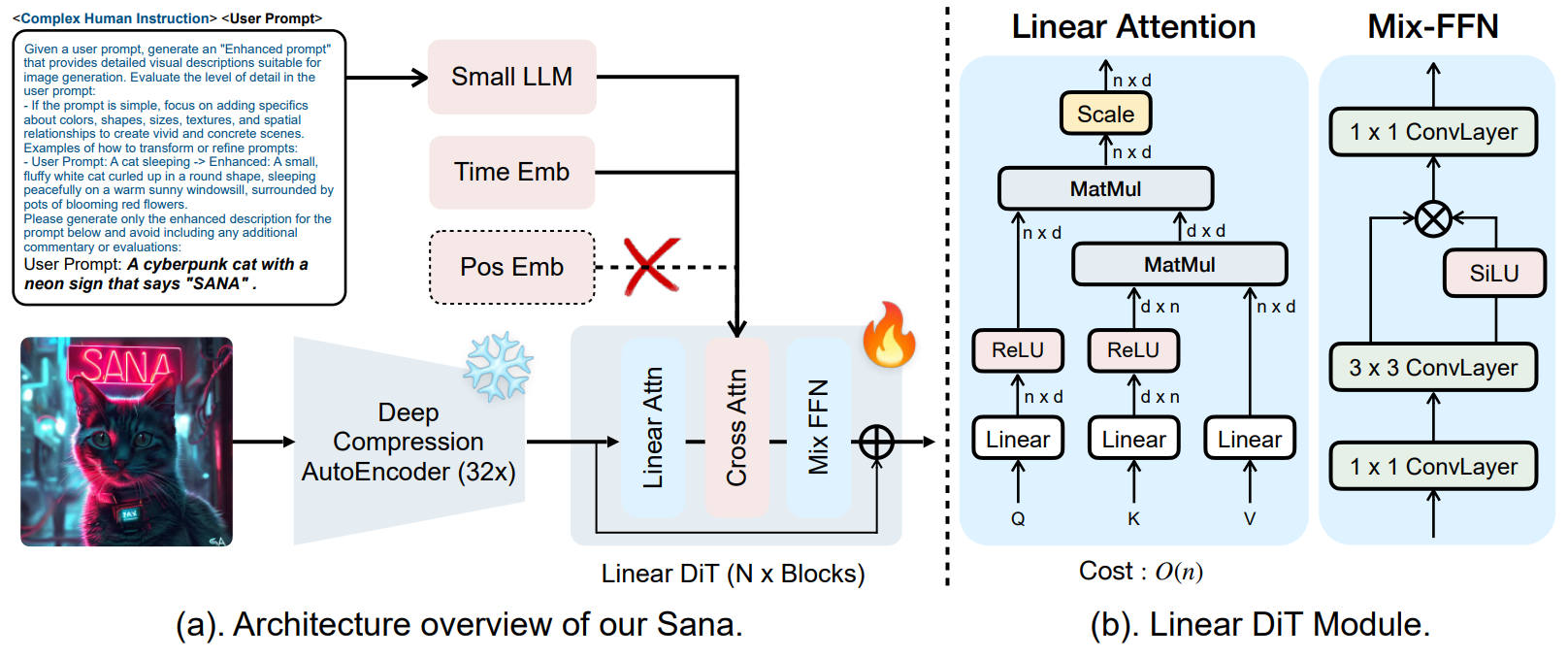

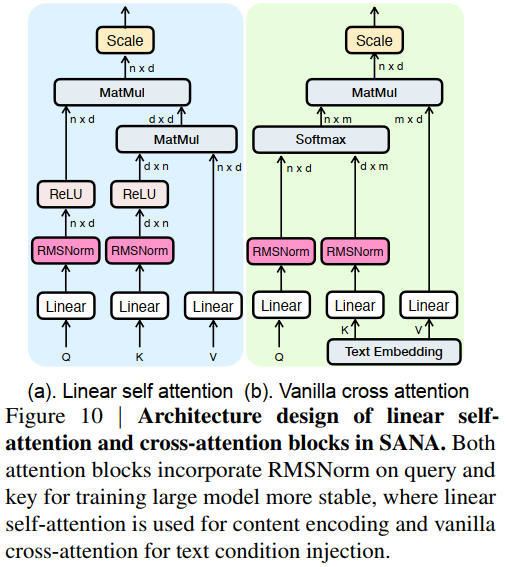

SANA

2025年

出典:SANA: Efficient High-Resolution Text-to-Image Synthesis with Linear Diffusion Transformers. Enze Xie et al. Figure 5. https://openreview.net/forum?id=N8Oj1XhtYZ

2025年

出典:SANA 1.5: Efficient Scaling of Training-Time and Inference-Time Compute in Linear Diffusion Transformer. Enze Xie et al. Figure 10. https://arxiv.org/abs/2501.18427

Linear Attention

アテンションは (QK)V の順で計算するが Linear Attention は Q(KV) の順で計算する。(QK) = n x n だが、(KV) = dmodel * dmodel 。通常のアテンションはトークン数が n とすると計算量とメモリ使用量とが O(n2) になるが、Linear Attention では O(n) になる。SD3 なら画像サイズが 1024 だと n は 4,096。

Linear Attention は高速だが性能は低下する。その低下分を Mix-FFN でカバーしている。Mix-FFN は RoPE を排除できるが、隠れ層の次元が dmodel = 2,240、dFFN = 5,600 と FFN の隠れ層の次元が巨大になっている。

畳み込み

3x3 の前の 1x1 の畳み込みによって計算量を削減している。1x1 の畳み込みはチャンネル数の次元を削減するのに使われることが多い。例えば (C, H, W) = (3, 8, 8) に 1x1 の畳み込みを実行して (1, 8, 8) にする。その後で計算コストの高い 3x3 の畳み込みを実行し、1x1 の畳み込みで (3, 8, 8) へチェンネル数を復元する。これはピクセル単位の MLP を実行しているとみることもできる。

畳み込みの出力次元数

\[ \begin{split} OH &= \dfrac{H + 2* \mathrm{padding} - \mathrm{filter size}}{\mathrm{stride}} + 1\\ OW &= \dfrac{W + 2*\mathrm{padding} - \mathrm{filter size}}{\mathrm{stride}} + 1 \end{split} \]Exploring 1x1 Convolutions in Deep Learning

パラメータ

dmodel = 2,240、dFFN = 5,600。

4.8B は 60 レイヤー。1.6B は 20 レイヤー。モデルサイズで隠れ層の次元は変わらない。

DiT-Air

ネットワークは Lumina-Image 2.0 とほぼ同じ。

DiT-Air: Revisiting the Efficiency of Diffusion Model Architecture Design in Text to Image Generation によると、テキストコンディショニングはクロスアテンションで取り込むのではなくノイズ画像と結合し、Normalize に AdaLN を使うのが最強らしい。

AdaLN のパラメータをレイヤー間で共有した場合、性能を変えずに 2.7 億個のパラメータを削減できる。アテンションレイヤー(QKVO)をレイヤー間で共有した場合、すべてのベンチでわずかに性能が低下するが、9,000 万パラメータの削減が可能。

結論としては AdaLN とアテンションレイヤーのウェイトを共有して、MLP のみ独立させるのが最もパラメータ効率が良い。

DiT-Air/L-Lite は総パラメータ数 1.15B で内訳は、CLIP/H(335M), DiT(700M), 8ch VAE(84M)。

隠れ層の次元は 64 * レイヤー数。

| モデル | レイヤー数 | 隠れ層の次元 |

|---|---|---|

| S | 12 | 768 |

| B | 18 | 1,152 |

| L | 24 | 1,536 |

| XL | 30 | 1,920 |

| XXL | 38 | 2,432 |

マルチヘッドアテンションの数はトランスフォーマーの深さと同じ。

Pixart と同じ MLP なら、トランスフォーマーブロックの隠れ層と同じ次元を持つ、2レイヤーの MLP。活性化関数は SiLU。

2025年

出典:DiT-Air: Revisiting the Efficiency of Diffusion Model Architecture Design in Text to Image Generation. Chen Chen et al. Figure 4. https://arxiv.org/abs/2503.10618

これは、DiT-Air/XXLでは、できる限り最も優れたモデルを提供したいと考えているためです。この場合、特に複雑なプロンプトや長文の文字表現においては、CLIP単独の場合よりも、CLIPとLLMを組み合わせることで、さらに良い性能が得られます。

— Chen Chen (@alex8937) March 14, 2025

Nitro-T

0.6B は PixArt-α に似たアーキテクチャ、1.2B は SD3 に似たアーキテクチャで、ブロック図はない。

MicroDiT で使用された Deferred Patch Masking を採用しパッチ化の性能が上がっている。

使用技術的に SANA に近い。SANA はパッチを使用しないが Nitro-T はパッチを使うところが相違点。

- テキストエンコーダーに軽量 LLM(Llama 3.2 1B)を使用

- テキストエンコーダーの出力に RMSNorm を通すことで loss を安定させている。

- VAE に 32 倍の圧縮率の DC-AE を使用

35M 枚数の学習画像の過半数が AI 生成(DiffusionDB と JourneyDB)の画像。

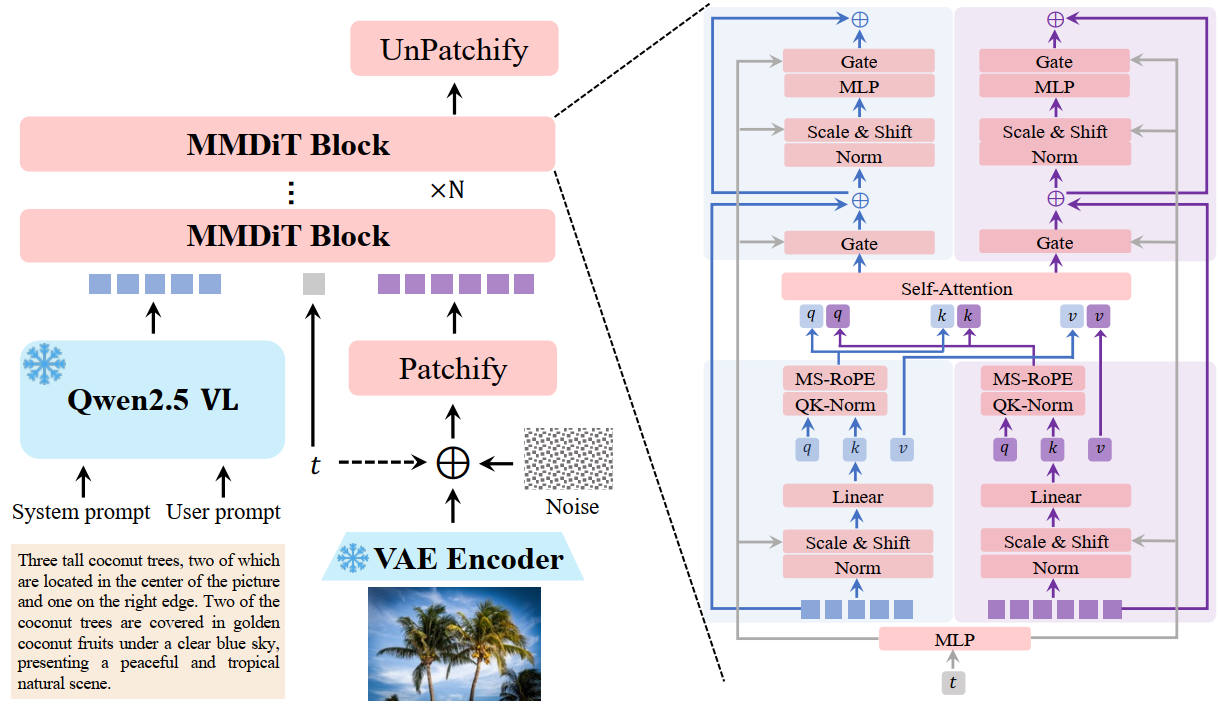

Qwen-Image

テキストエンコーダーに LLM を使い、SD3 を現代的にアップデートしたようなアーキテクチャ。

PixNerd: Pixel Neural Field Diffusion

DiT で Neural Field MLP を計算し、Neural Field MLP にピクセル座標を入力して Diffusion velocity を計算する。

VAE が不要で効率的。

数式

PE(i, j) はピクセル座標 i, j を任意の次元 L にエンコーディングする。

\[ PE(i,j) = \mathrm{sin}(2^0\pi i), \mathrm{cos}(2^0\pi i), ..., \mathrm{sin}(2^L\pi i), \mathrm{cos}(2^L\pi i), ...\mathrm{sin}(2^L\pi j), \mathrm{cos}(2^L\pi j) \]DiT にノイズ画像・タイムステップ・キャプションを入力し、$X^n$ を出力する。$X^n$ は n 番目のトークン。$X^n$ を SiLU と Linear で変換して $W_1^n \in \mathbb{R}^{D_2\times D_1}, W_2^n \in \mathbb{R}^{D_1 \times D_2}$ を得る。

\[ W_1^n, W_2^n = \mathrm{Linear}(\mathrm{SiLU}(X^n)) \]$v^n(i,j)$ は PE とノイズ画像 $x^n(i,j)$ から速度 v を計算する。$x^n(i,j)$ は n 個目のノイズ画像。学習を安定させるため W は行ごとに正規化されている。

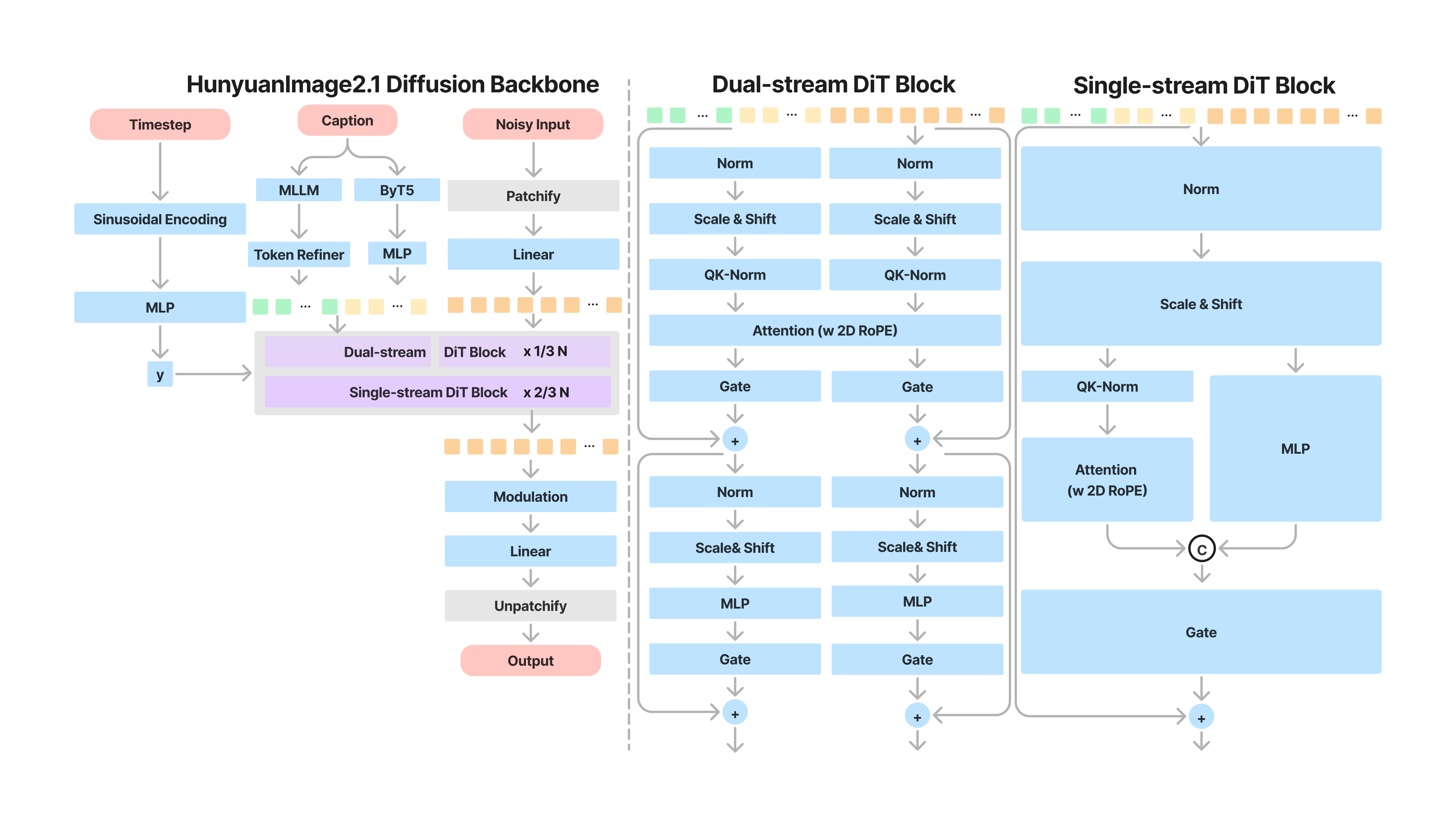

\[ v^n(i,j) = \mathrm{Linear}(\mathrm{MLP}(\mathrm{Concat}([PE(i,j), x^n(i,j)]) | {\dfrac{W_1^n}{||W_1^n||}, \dfrac{W_2^n}{||W_2^n||}})) \]HunyuanImage-2.1

FLUX とほぼ同じアーキテクチャで テキストエンコーダーに MLLM を使用している。ふたつ目のテキストエンコーダーの ByT5 はテキスト生成と多言語表現に特化してる。

SANA や Nitro-T のような 32 倍圧縮の VAE を使用し、DINOv2 を使用した REPA で効率的に学習。

HunyuanImage-2.1 の差別化ポイントは、プロンプトを水増しする Prompt Enhancer モデルと、キャプションと画像とから生成画像の品質を評価する Align Evaluator とを作成し強化学習に使っているところ。

HunyuanImage-3.0

パラメータ数 80B、アクティブ 13B、エキスパート数 64、アクティブエキスパ―ト 8。

ChronoEdit

2025 年 11 月。動画生成 AI を使用し TI2V で動画を生成、最終フレームを出力画像とする。直接最終画像を出力する画像編集モデルは、はめ込み合成のような画像を出力することがある。ChronoEdit は動画生成 AI を利用することで、中間フレームを reasoning フレームとして利用して品質を改善する。

FLUX.2

- テキストエンコーダーに Mistral Small 3.1(24B)を使用。max_sequence_length は 512

- FLUX.1 同様に、デュアルストリームの後にシングルストリームになる

- シングルストリームのブロックは並行 DiT。通常はアテンションの後に FFN を計算するが、並行 DiT はアテンションと FFNとを同時に計算する(つまりアテンション後の FFN がない)

- ローカルでは恩恵がないが、複数 GPU がある環境ならアテンションと FFN とを並列計算できる

- デュアルストリームブロック8に対しシングルストリームブロック 48

- AdaLNZero はパラメータ共有

- 全レイヤー bias なし

- SwiGLU に近い構造の FFN を使用

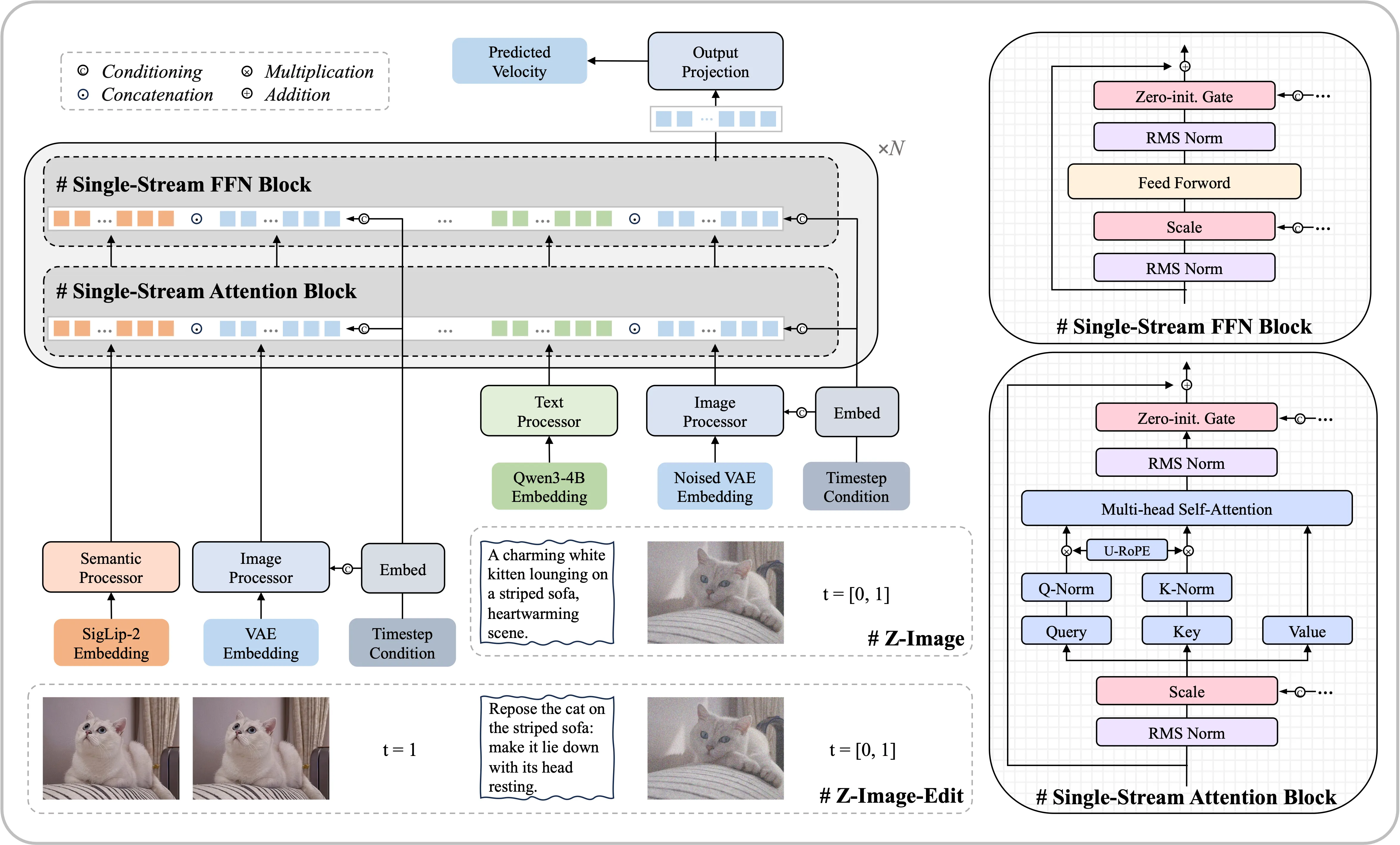

Z-Image-Turbo

すべてシングルストリームブロック。RoPE は Lumina-Image 2.0 でも使われた 3D Unified RoPE。

以下の入力すべてが連結して入力される。

- SigLip-2 Enbedding(Image Edit の場合)

- VAE Embedding(Image Edit の場合)

- プロンプト

- ノイズ画像

タイムステップは AdaLN-Zero にも入力される。画像編集タスクでは参照画像とノイズ画像とを区別するため、参照画像とノイズ画像とは別々のタイムステップでコンディショニングされる。

SigLip-2 Enbedding

SigLip v2 は SigLip v1 と互換性がある。SigLip v1 のモデルに新たな複数の損失(LocCa, TIPS, SILC)とデータセットとを追加して訓練したモデルだからだ。

AIDC-AI/Ovis-Image-7B

2025年 11 月。テキスト描画に強いモデル。構造は FLUX.1 と同じ。

meituan-longcat/LongCat-Image

2025年 12 月。6B の軽量 FLUX のようなアーキテクチャ。

Qwen-Image-Layered

2025年 12 月。画像をレイヤー分解+アルファ付きに変換する。

GLM-Image

2026年1月。AR で画像を描画し、テキストの修正に拡散モデルを使う。

データセット

データとパラメータ数はセットで考える。パラメータ数だけ増やしても性能は上がらない。データに多様性がなければデータを増やしても性能は上がらない。

最近では多くても 50M 程度の教師画像枚数で学習させることが多い。仕上げのファインチューニングは1~3M枚。

MicroDiT では、生成した画像の品質評価をするために ChatGPT にどちらの画像が質が高いか質問した。プロンプトは「Which image do you prefer, Image A(first) or Image B(second), considering factors like image details, quality, realism, and aesthetics? Respond with 'A' or 'B' or 'none' if neither is preferred.」これは、ローカルの Gemma3 でも実行できる。意味があるかどうかはわからないが「Tell me the reason.」で理由も聞ける。データセットの画像の厳選にも使える。

Sub-Scaling Laws: On the Role of Data Density and Training Strategies in LLMs

LLM ではモデルのパラメータ数が増えると性能向上率が悪化する。その原因はデータの多様性の不足と、学習のさせすぎだ。

論文ではデータをクラスタ分けしてデータの多様性を計測する方法や、Over-Training Ratio の概念を紹介している。

Achieving 10,000x training data reduction with high-fidelity labels

広告分類タスクで、ファインチューニングに必要なデータ量を1万分の1にする。

データをクラスタリングして、境界線上にあり、複数のクラスタに属しているものをファインチューニングに使う。

NoHumansRequired: Autonomous High-Quality Image Editing Triplet Mining

画像・修正指示・修正後の画像のデータセット、の公開と、データセットの作成方法についての解説。

Alchemist: Turning Public Text-to-Image Data into Generative Gold

拡散モデルを使って、大量の学習画像の中から、その拡散モデルで学習効率のいい SFT 用のデータをフィルタリングする。

- NSFW フィルタ

- 解像度フィルタ

- 美的フィルタ

- ウォーターマークフィルタ

- 粗い品質フィルタ

- 圧縮ノイズ

- モーションブラー

- 露出ミス

- 詳細な品質フィルタ

- 重複除去(類似画像も除去し最も美的スコアが高いものを残す)

- 拡散モデルを使用したフィルタ

- キャプションに "high quality", "artistic", "aesthetic", "complex" などを入れ、I2I を実行してクロスアテンションの出力を見る。

著作権について

平成30年著作権法改正により学習は合法。ただしモデルが著作権侵害コンテンツを高頻度で生成する場合、モデルの公開・販売や画像生成サービスの提供は複製権侵害になる。

danbooru タグの artist, copyright, character タグを学習させたモデルは複製権侵害のリスクが非常に高い。

便利ツール

データセット

データセットは画像 URL とキャプションとのペアで提供される。画像のライセンスは画像の所有者ごとに異なる。以下のリストのライセンスが書いていないデータセットの画像のライセンスは画像所有者依存。

商用利用可能な大規模なデータセットは flicker ぐらいしかない。flicker は CC0 で画像を提供すれば無限のストレージが利用できる。

よく使われるデータセット

ImageNet:商用不可

Segment Anything 1B(Meta):Apache 2.0 License だが商用利用不可

AI 生成画像(多様性があり学習に使うと性能が上がる)

JourneyDB:商用不可。商用利用したければプロンプトから自作すればよい。$100万を超える売り上げのある企業は有料プランに加入しないと資産を所持できない。Midjourney は著作権侵害コンテンツを平気で生成してくるので、プロンプトと生成した画像との厳選は必要になる。

CC0

soa-full-florence2 はスミソニアン協会が公開している情報をもとにmadebyollin氏が作成したCC-0の絵画などを集めた画像リンク集。古いものが多く、メインのデータセットにはならない。

flicker

megalith-10m(flicker 画像のキュレーション)

次点

Open Images Dataset V7(Google):画像は CC BY 2.0 だが個々の画像のライセンスには Google は関知しない、キャプションは CC BY 4.0

DOCCI Descriptions of Connected and Contrasting Images

Unsplash:Unsplash ライセンス(商用可能、転売は不可)

LAION-5B:低品質な画像が多く使われなくなってきている

データの水増し

OmniGen2 は動画から画像を切り出して、学習に使用している。

Magpie: Alignment Data Synthesis from Scratch by Prompting Aligned LLMs with Nothing。LLM のケースだが、AI にデータを作成させる方法の紹介。

データの分類

OmniGen2 ではデータを以下のように分類し、均等になるようにしている。

- キャラ

- 男

- 女

- 子供

- 老人

- アニメキャラ

- オブジェクト

- バーチャル

- 食べ物

- 人工物

- 植物

- 動物

- シーン

- コマーシャル

- ランドマーク

- 地方(Domestic)

- 都市(Urban)

- 自然(Natural)

キャプショニング

データセットが提供するキャプションを使うのではなく、LLM で画像のキャプション付けを行うのが一般化している。

解像度を下げる場合は、キャプションを作り直す必要はない。しかし画像をクロップした場合は、キャプションを作り直す。

danbooru タグを使う方が細かい制御が効くので、自然言語のキャプションと danbooru タグのキャプションとをランダムキャプショニングで学習させる方が便利。

LLM で以下の情報を抽出する。単に「車」と記述するのではなく、「通りを走る車」のようにアクションを記述させる。

- 人

- 人数

- 人の表情・感情

- ポーズ・姿勢:例:「走っている子供」、「ベンチに座っている人」

- 身体属性:例:「長い金髪の女性」、「ふわふわの毛の犬」

- 年齢・身長・性別

- 相互作用:例:「握手している二人」、「ボールで遊んでいる犬」

- 服の種類

- 物

- 物の画面内での位置

- オブジェクト間の相対的位置

- 物色、パーツの色

- 形状

- 材質

- サイズ

- 動物の種類

- 背景の詳細: 例:「都市の景観」、「穏やかな森」

- 室内か屋外か

- 全体的な雰囲気/ムード:例:「賑やかな通り」、「平和な庭」

- カメラ・ポストエフェクト(blurry background, chromatic aberration, from below など)

- 人や物の位置関係

- 文字の位置と文字

- 時間帯

- 照明条件:例:「明るい昼光」、「薄暗い夕方の光」

- 季節

- 天候

ランダムキャプショニング

キャプションが複数ある場合は、キャプションをクリップスコアで評価し、正規化することで確率的にキャプションを選択する手法がある。

\[P(c_i) = \frac{exp(c_i/\tau)}{\sum_{j=1}^N exp(c_j/\tau)} \]c は CLIP スコアで、t は温度。0に近い値にすると常に最も高いスコアのキャプションが選択される。

長すぎるプロンプト問題

DetailMaster: Can Your Text-to-Image Model Handle Long Prompts? では長すぎるプロンプトが性能を低下させることを報告している。

The Intricate Dance of Prompt Complexity, Quality, Diversity, and Consistency in T2I Models

キャプションの長さと美的スコアや多様性を調査した論文。キャプションが長いと多様性が低下し再現性が向上するが、美的スコアが低下する。美的スコアを最大化するにはキャプションは長すぎても短すぎてもよくないことを明らかにした。

Collage Prompting

従量課金の MLLM は画像枚数あたりで課金されるため、Collage Prompting では複数の画像を1枚にまとめてキャプションを作成する方法を紹介している。

danbooru タグを利用したプロンプト例

Deepdanbooru 等でタグをつけて、そのタグを LLM・VLM に入力する。

画像につけられたタグを参考に画像のキャプションを作成してください。余計な応答は出力せず、キャプションだけを出力してください。 # 方針 - 人物の位置(左・中央・右)やオブジェクトの位置(上下左右)は必ず書いてください - テキストが存在する場合はダブルクオート "" で囲んでください - 服装・表情・髪や服の色・ポーズ・髪型は必ず書いてください。 # タグ danbooru タグのリスト 余計な応答は出力せず、キャプションだけを出力してください。

プロンプト例

| カテゴリ | 説明 | プロンプト |

|---|---|---|

| 直接キャプショニング | 画像全体を包括的に記述する。MLLMのゼロショット能力を活用。 | 「この画像を詳細に記述してください。」 「画像の内容を包括的な段落で説明してください。」 |

| きめ細かい指示生成(Q&A形式) | 特定のオブジェクト、属性、関係性について質問と回答のペアを生成させる | 「画像内のオブジェクトの色、サイズ、素材、形状について質問と回答のペアを生成してください。」 「画像内の人物の行動と、彼らが他のオブジェクトとどのように相互作用しているかについて質問と回答を生成してください。」 |

| 属性ベースの拡張 | 既存の簡潔なキャプションに、きめ細かい属性(色、サイズなど)や空間的関係を追加して詳細化させる。 | 「このキャプションを、画像内のすべてのオブジェクトの具体的な色、サイズ、素材、形状、およびそれらの正確な空間的配置を含めて拡張してください。」 |

| シーン・文脈の豊かさ | 画像の全体的な雰囲気、照明、時間帯、背景の詳細などを記述させる。 | 「この画像の全体的なムード、時間帯、照明条件、および背景の環境を詳細に記述してください。」 |

| 人物・動物のインタラクション強調 | 画像内の人物や動物の行動、感情、相互作用に焦点を当てて記述させる。 | 「画像内の人物の表情、ポーズ、および彼らが互いに、または周囲のオブジェクトとどのように相互作用しているかを詳しく説明してください。」 |

| T2Iモデル向け最適化 | T2Iモデルの訓練データ分布に合わせた構造や表現でキャプションを生成させる。 | 「Text-to-Imageモデルのプロンプトとして最適化された形式で、この画像を記述してください。タグ形式または詳細な段落形式で、可能な限り多くの視覚的詳細を含めてください。」 |

| コスト効率化(コラージュプロンプティング) | 複数の画像を1つの入力として処理し、それぞれの詳細を記述させる。 | 「提供されたコラージュ内の各画像を個別に識別し、それぞれについて詳細なキャプションを生成してください。」 |

参考文献

Unleashing Text-to-Image Diffusion Prior for Zero-Shot Image Captioning

To See is to Believe: Prompting GPT-4V for Better Visual Instruction Tuning

DetailMaster: Can Your Text-to-Image Model Handle Long Prompts?

L-CLIPScore: a Lightweight Embedding-based Captioning Metric for Evaluating and Training

キャプション付けをするモデルを訓練する際に、モデルの書いたキャプションが正しいかどうか評価する必要がある。BLUE や CIDEr はキャプションが正しいかどうかの判定に、ある単語を含むかどうかで評価する。これは問題が多い。パラフレーズを評価できないし、間違った文や語に対するペナルティもほとんどない。

エッジデバイス向けの論文。

プロンプト例

Improving Image Generation with Better Captions

Prompting Vision Language Models

Synth2: Boosting Visual-Language Models with Synthetic Captions and Image Embeddings

Improving face generation quality and prompt following with synthetic captions

Dual Caption Preference Optimization for Diffusion Models

Structured Captions Improve Prompt Adherence in Text-to-Image Models (Re-LAION-Caption 19M)

スケジューラー

DDPM

\[ x_t = \sqrt{\bar{\alpha}_t}x_0 + \sqrt{1-\bar{\alpha}}\epsilon, \; \epsilon \sim \mathcal{N}(0, I) \\ \alpha_t = 1 - \beta_t, \; \bar{\alpha}_t = \prod^t_{i=1}\alpha_i \\ \sigma_t = \sqrt{1-\bar{\alpha}_t} \]Linear beta schedule

\[ \beta_t = \beta_{\mathrm{min}} + \dfrac{t-1}{T-1}(\beta_{\mathrm{max}} - \beta_{\mathrm{min}}) \]import torch

def ddpm_linear_sigma(T, beta_min=1e-4, beta_max=0.02, device="cpu"):

betas = torch.linspace(beta_min, beta_max, T, device=device)

alphas = 1.0 - betas

alpha_bar = torch.cumprod(alphas, dim=0)

sigmas = torch.sqrt(1.0 - alpha_bar)

return sigmas # shape: [T]

Cosine schedule (Improved DDPM)

Alex Nichol, Prafulla Dhariwal, Improved Denoising Diffusion Probabilistic Models

\[ \large{ \bar{\alpha}_t = \dfrac{\mathrm{cos}^2 ( \frac{t/T+s}{1+s} \frac{\pi}{2} )} {\mathrm{cos}^2 ( \frac{s}{1+s} \frac{\pi}{2} )} \\ \sigma_t = \sqrt{1-\bar{\alpha}_t} } \]import torch

import math

def cosine_sigma(T, s=0.008, device="cpu"):

t = torch.arange(T + 1, device=device)

f = torch.cos((t / T + s) / (1 + s) * math.pi / 2) ** 2

alpha_bar = f / f[0]

sigmas = torch.sqrt(1.0 - alpha_bar[1:])

return sigmas # shape: [T]

Karras sigma schedule (Stable Diffusion /EDM 系)

Karras et al. Elucidating the Design Space of Diffusion-Based Generative Models

現在の画像生成で最も実用的に使われている σ 定義。

- $\sigma_{\mathrm{max}}$:初期ノイズ

- $\sigma_{\mathrm{min}}$:最終ノイズ

- $\rho$:分布形状(典型値7)

import torch

def karras_sigmas(

n_steps,

sigma_min=0.002,

sigma_max=80.0,

rho=7.0,

device="cpu",

):

i = torch.linspace(0, 1, n_steps, device=device)

sigmas = (

sigma_max ** (1 / rho)

+ i * (sigma_min ** (1 / rho) - sigma_max ** (1 / rho))

) ** rho

return sigmas # shape: [n_steps]

EDM 系では、σ がモデル入力の正規化・損失重みにも直接使われる:

\[ \lambda(\sigma) = \dfrac{1}{\sigma^2} \]学習方法

低解像度で学習した後、高解像度の学習を行い、最後に高品質な画像だけを使った仕上げを行う。

8倍圧縮の VAE の場合は 256 x 256 の解像度で事前学習を行うが、32 倍圧縮の VAE を使う SANA や Nitro-T では 512 x 512 から事前学習を始めている。

Scaling Laws For Diffusion Transformers によると、事前学習の loss もスケーリング則に従う。スケーリング則から、最適なモデルサイズと必要なデータセットの量が計算できる。

Pre-training under infinite compute によると、データ制約下では正則化とアンサンブル学習で性能を向上させられる(ただし大量の計算リソースが要求される)。

Exponential Moving Average of Weights in Deep Learning: Dynamics and Benefits

エポックごとにモデルのコピーを保存しておいて、EMA を使ってモデルの平滑化を行う。たいていは学習の最終段階のファインチューンの時にのみ行われる。

サンプルコードは Model EMA (Exponential Moving Average) を参照。

On the Scalability of Diffusion-based Text-to-Image Generation

隠れ層の次元を増やすよりトランスフォーマーブロックを増やした方が性能が上がる。データセットは質と多様性が重要で、量は重要ではない(現状十分な量の画像が手に入る)。

マスク

MaskGIT: Masked Generative Image Transformer ノイズ+マスクで学習させる。

MADI: Masking-Augmented Diffusion with Inference-Time Scaling for Visual Editing ノイズ+マスクで学習し、推論時にはパディングトークンを追加することで性能を上げる。

Classifier Free Guidance

一定確率(10%前後)でキャプションなしで学習させることで、CFG が使えるようになる。CFG は品質を大きく向上させるが、蒸留モデルでは使えないことが多い。蒸留モデルのみを公開する場合は CFG 学習をしない選択もある。

Adaptive Projected Guidance

ELIMINATING OVERSATURATION AND ARTIFACTS OF HIGH GUIDANCE SCALES IN DIFFUSION MODELS

CFG をデノイズ画像と直交する方向と平行方向とに分解したとき、平行方向ベクトルが彩度を高めることを発見した。なので直交方向のみスケールを効かせることで高い CFG での高彩度化を抑えることに成功した。

APG に追加の学習は不要で CFG が使えれば使える。

DiffIER: Optimizing Diffusion Models with Iterative Error Reduction

CFG のエラー補正技術。

S2-GUIDANCE: STOCHASTIC SELF GUIDANCE FOR TRAINING-FREE ENHANCEMENT OF DIFFUSION MODELS

S2-GUIDANCE は CFG に加えて、タイムステップごとにランダムに DiT ブロックを一つスキップしたものを引き算する。

CFG 比で性能は向上するが、1ステップに3回推論する(CFG は2回)ので、費用対効果は悪い。

Normalized Attention Guidance: Universal Negative Guidance for Diffusion Models

プロンプトとネガティブプロンプトとでアテンションの KV を作成し、引き算することで CFG と同等のことができる。

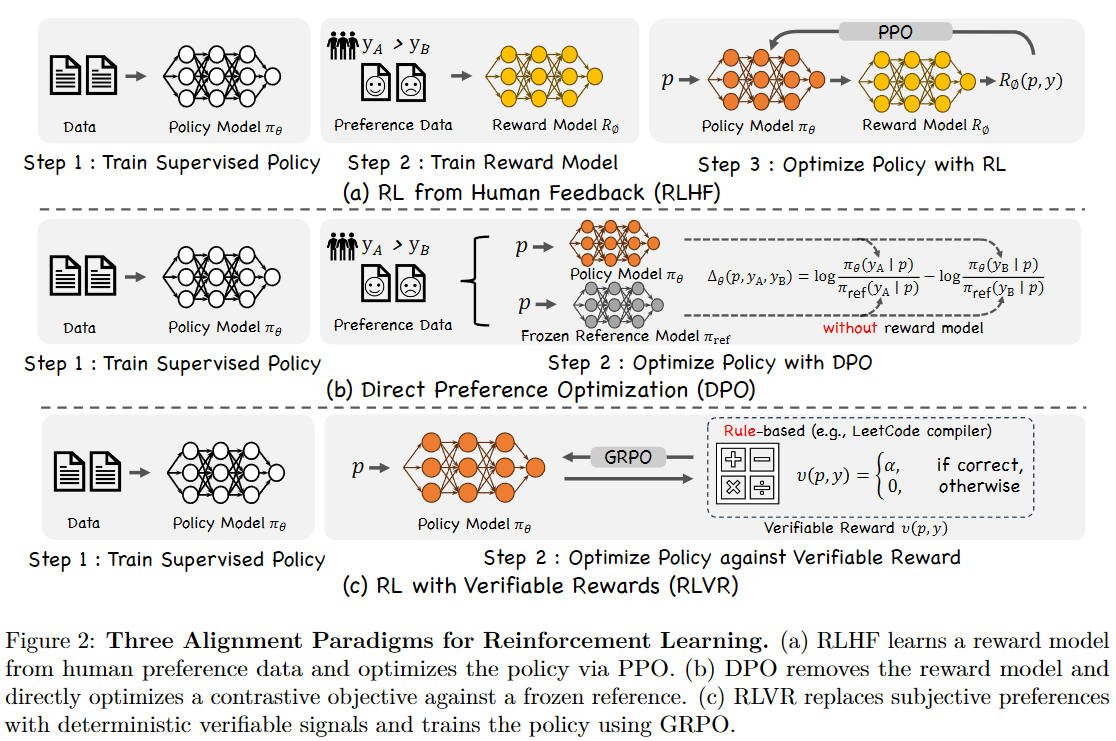

Reinforcement Learning Guidance

強化学習は本質的に CFG の学習と同じなので、強化学習なしのモデルのノイズ予測から、強化学習済みのモデルのノイズ予測を引くことで CFG のように動的に強化学習の影響力を調整できる。

強化学習のモデルを LoRA 化する方が便利だと思われる。

Inference-Time Alignment Control for Diffusion Models with Reinforcement Learning Guidance

学習率スケジューラー

CosineAnnealingLR のような学習率が上下するスケジューラーは局所的最適解を避けられる。

from torch.optim import lr_scheduler

# T_max: 学習率が最小値に達するまでのエポック数。総エポック数の 1/5 程度が目安

# eta_min: 学習率の最小値。0に設定するコード例が多いが、計算資源の無駄でしかない

scheduler = lr_scheduler.CosineAnnealingLR(optimizer, T_max=20, eta_min=1e-5)

# optimizer.step() の代わりに scheduler.step() を呼び出す

scheduler.step()

タイムステップスケジューラー

タイムステップは通常 0~1,000 の間でランダムに選択される。

A Closer Look at Time Steps is Worthy of Triple Speed-Up for Diffusion Model Training によると、タイムステップの後半は Loss が小さく学習が遅いので、前半(250 前後)に集中して学習させることで3倍学習が高速になる。

Disentanglement in T-space for Faster and Distributed Training of Diffusion Models with Fewer Latent-states

タイムステップを 1,000 より少なくした方が学習が速いという論文。T=8 だと性能が低いが、T=16 以上は性能差がほとんどない。

ノイズスケジューラー

ノイズスケジューラーのまとめは Noise schedules considered harmful を参照。

Stable Diffusion 1.5 や XL はスケジューラーにバグがあり、色の再現性の低下や高解像度での分裂などの問題を引き起こしていた。Stable Diffusion 3 ではタイムステップを以下の式で変換することで高解像度での分裂等に対処している。色の再現性は ZTSNR や Rectified Flow を採用することで改善されている。

\[ \displaylines{ \begin{split} t_m &= \dfrac{\sqrt{\frac{m}{n}} t_n}{1 + (\sqrt{\frac{m}{n}}-1)t_n}\\ {t_m} &{= 変換後のタイムステップ}\\ {t_n} &{= 変換前のタイムステップ}\\ {n} &{= ベース画素数。SD3 は 1,024 \times 1,024}\\ {m} &{= 生成する画像の画素数} \end{split} } \]

${x_t = \sqrt{\gamma}\cdot x_0 + \sqrt{1-\gamma}\cdot \epsilon : \gamma = 0.7}$

高解像度の画像の情報を破壊するにはより多くのノイズが必要になる

出典:On the Importance of Noise Scheduling for Diffusion Models. Ting Chen. Figure 2

ZTSNR(Zero Terminal SNR)

Common Diffusion Noise Schedules and Sample Steps are Flawed では、T=1000 まで学習すべきなのに T=999 で止まるノイズスケジューラーのバグを指摘している。

Input Perturbation Reduces Exposure Bias in Diffusion Models

学習時、ネットワークは実際の画像にノイズを乗せたものを使って学習するが、推論時には自分の推論結果からノイズを徐々に除去していく。これは exposure bias 問題に似ていて、エラーが蓄積していく。

そこで学習時に追いノイズによってこのバイアスを除去する。以下の式の $ \sqrt{1+\gamma^2}$ が追いノイズの部分。

\[ \begin{split} \mathbf{y} &= \sqrt{\bar{\alpha}_t \mathbf{x}_0} + \sqrt{1-\bar{\alpha}_t}\sqrt{1+\gamma^2}\mathbf{\epsilon}\\ \gamma &= 0.1 \end{split} \]A Comprehensive Review on Noise Control of Diffusion Model

以下のノイズスケジューラーのレビュー。

- Linear

- Fibonacci

- Cosine

- Sigmoid

- Exponential

- Cauchy distribution

- Laplace distribution

- Logistic

- Monotonic neural network

高解像度では Cosine より Sigmoid の方が良い。

Improved Noise Schedule for Diffusion Training

ノイズスケジューラ―の Laplace, Cauchy は logSNR=0(つまり純粋なノイズ)の時の学習効率と品質がよい。

参考文献

Common Diffusion Noise Schedules and Sample Steps are Flawed

On the Importance of Noise Scheduling for Diffusion Models

Diffusion Noise Optimization (DNO)

Noise schedules considered harmful

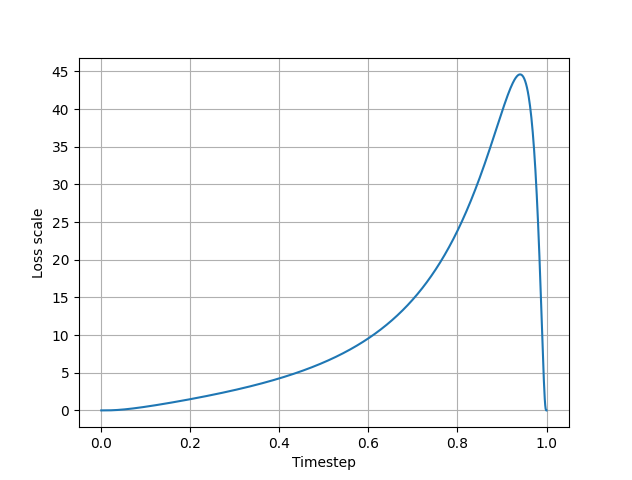

損失関数の重みづけ

Debiased Estimation Loss

モデルの再構成誤差に $ \dfrac{1}{\sqrt{\mathrm{SNR(t)}}}$ を掛けるだけ。v prediction の場合は、$ \dfrac{1}{\mathrm{SNR(t)} + 1} $。

\[ \begin{split} L &= \sum_t \mathbb{E}_{x_0,\epsilon} \left[ \frac{1}{\sqrt{\mathrm{SNR(t)}}} ||\epsilon - \epsilon_{\theta}(x_t, t)||^2 \right]\\ \alpha :&= \prod^t_{s=1}(1-\beta_s)\\ \mathrm{SNR}(t) &=\dfrac{\alpha_t}{1-\alpha_t} \end{split} \]Rectified Flow の場合

SD3 では以下の式で損失関数を重みづけしてる。ノイズが大きい部分のウェイト大きくなる。T=0, 1 の時ウェイトが0に近い。$ \lambda^{\prime}$ は SN 比の微分。

\[ \begin{split} \mathrm{logit}(t) &= \mathrm{log} \; \dfrac{t}{1-t}\\ \pi_{\mathrm{ln}}(t;m,s) &= \dfrac{1}{s\sqrt{2\pi}}\dfrac{1}{t(1-t)} \mathrm{exp} \left (-\dfrac{(\mathrm{logit}(t)-m)^2}{2s^2}\right ) \end{split} \]

横軸はタイムステップ、縦軸は$\pi_{ln}(t; 0.00, 1.00)(\dfrac{\sigma_t\lambda^{\prime}_t}{2})^2$

$\lambda^{\prime} = 2(\frac{a^{\prime}_t}{a_t} - \frac{b^{\prime}_t}{b_t})$

$\sigma_t = a = t$

$b = 1 - a$

a' と b' はそれぞれ a と b の微分

プロットコード

import math

import matplotlib.pyplot as plt

num_sample = 1000

#f = lambda x: x

old_a = 0

old_b = 1

dt = 1/num_sample

def f(t,m=0,s=1):

if t==0 or t==1:

return 0

global old_a, old_b

a = t # [0, 1]

b = 1 - a

sigma_t = t

logit = lambda x: math.log(x) - math.log(1-x)

coeff = 1/(s*math.sqrt(2*math.pi) * t * (1-t))

logit_coeff = coeff * math.exp(-(logit(t)-m)**2 / 2*s*s)

diff_a = (a - old_a)/dt

diff_b = (b - old_b)/dt

diff_lambda = 2*(diff_a/a - diff_b/b)

old_a = a

old_b = b

return logit_coeff * (sigma_t * diff_lambda / 2)**2

inputs = [i/num_sample for i in range(num_sample+1)]

outputs = [f(x) for x in inputs]

title = ''

label_x = 'Timestep'

label_y = 'Loss scale'

flg = plt.figure()

ax = flg.add_subplot()

ax.plot(inputs, outputs)

ax.set_title(title)

ax.set_xlabel(label_x)

ax.set_ylabel(label_y)

# グリッド線

ax.grid(axis='x') # グリッド線の表示:X軸

ax.grid(axis='y') # グリッド線の表示:Y軸(点線)

ax.set_yticks(range(0, 50, 5))

flg.show()

plt.show()Huber loss

学習速度と外れ値の影響力にはトレードオフがある。学習速度の速い L2 loss は外れ値に弱い。L1 smooth は外れ値に強いが学習は遅い。

Huber loss は δ を変化させることで L2 と L1 の中間を作れる。 δ を上げるとなだらかな L2 に近くなり、下げると L1 に近くなる。

\[ H_\delta(x) = \delta^2 \left ( \sqrt{1+\dfrac{x^2}{\delta^2}-1} \right ) \]Improving Diffusion Models's Data-Corruption Resistance using Scheduled Pseudo-Huber Loss

小さいモデルを先に訓練する

SANA 1.5 では 1.6B を作成した後、学習済みの 1.6B にブロックを追加して 4.8B にしてから学習させることで、4.8B の学習時間を 60% 削減している。

蒸留

性能向上の面から見れば小さいモデルは、大きなモデルから蒸留した方が性能はよくなる。

詳細は蒸留技術まとめを参照。

Subliminal Learning: Language models transmit behavioral traits via hidden signals in data

蒸留するモデルのアーキテクチャが同じ場合、教師モデルの欠点も伝達されることを発見した。これは教師モデルの出力から問題のある出力をフィルタリングしても伝播を防げない。

しかしモデルのアーキテクチャを変えたり、インコンテキスト学習を利用した場合はこの現象は起こらない。つまりデータに問題があるのではなく、モデルとデータの組み合わせの問題の可能性が高い。

大きいモデルのブロックを削減して小さいモデルを作成する

SANA 1.5 では大きなモデルの推論時のブロックの入力と出力との類似度を計算し、性能に貢献していないブロックを削除する。その後でファインチューニングすることで小さいモデルを作成している。ブロック削除後のファインチューニングはたった 100 ステップ程度で十分。

SLEB: Streamlining LLMs through Redundancy Verification and Elimination of Transformer Blocks ではトランスフォーマーブロックの入力と出力との類似度をコサイン類似度で計算している。

Do Language Models Use Their Depth Efficiently? はコサイン類似度と残差ストリームとを使用して分析している。

画像編集

画像編集の学習時にノイズの乗った画像と元画像とを結合して入力する。これによって、モデルは元画像を常に参照できるので不要な部分を変更しない編集の性能が上がる。

画像編集はプロンプトでマスクを作成し、マスク部分に I2I を実行しているだけだ。画像のマスクと違い、プロンプトマスクは潜在空間ベクトルレベルでマスク可能なのが違いだ。

- FLUX.1 Kontext: Flow Matching for In-Context Image Generation and Editing in Latent Space

- Qwen-Image Technical Report

- HIVE: Harnessing Human Feedback for Instructional Visual Editing

Stable Diffusion Models are Secretly Good at Visual In-Context Learning

セルフアテンションの K, V にタスクに対応した画像を入力すると、学習していなくても以下のタスクが実行できる。これはモデルの再学習なしで実現可能。

- セグメンテーション

- セマンティックセグメンテーション

- 物体検出

- キーポイント(関節など)検出

- 輪郭抽出

- 彩色

省メモリ学習

省メモリ技術

- 8-bit Optimizers(AdamW, CAME)

- Gradient Checkpointing

- Gradient Accumulation(バッチサイズによるが、最もメモリ削減効果が大きい)

- Freezing embeddings

- AMP(Automatic Mixed Precision)(NVIDIA GPU のみ。Tensor コア使用。学習が最大2倍高速化する効果もある)

8-bit Optimizers

8bit AdamW は bitsandbytes をインストールすると使える。ただし CNN を多用する VAE では効果は小さい。

bitsandbytes

枯れたバージョンの CUDA を使用しているなら普通にインストールする。

!python -m pip install bitsandbytes

使用している CUDA のバージョンに対応したものをインストール場合。CUDA のバージョンチェックは nvidia-smi。

!python -m pip install bitsandbytes-cuda111

使えるかどうかは python -m bitsandbytes で以下のメッセージが出るか調べる。

PyTorch settings found: CUDA_VERSION=124, Highest Compute Capability: (8, 6). Checking that the library is importable and CUDA is callable... SUCCESS!

使用方法

import bitsandbytes optimizer = bitsandbytes.optim.AdamW8bit(model.parameters(), lr=learning_rate)

Gradient Checkpointing

Training Deep Nets with Sublinear Memory Cost

勾配の計算には各ブロックのフォワードパスの結果を保存しておく必要がある。しかしこれはメモリ使用量が大きい。そこで、チェックポイントに指定したブロックのみフォワードパスの結果を保存しておき、バックプロパゲーション時にフォワードパスの結果が必要になると、一番近いチェックポイントからフォワードパスの結果を再計算する。

メモリ使用量が減るが、学習時間が増加する。

バッチサイズ

大きい場合

利点

- 学習時間の短縮

- 勾配推定の安定性。勾配が均されるため、ノイズが減り学習が安定する

欠点

- 汎化性能の低下。 勾配のノイズが少ないため、局所最適解・sharp minimaに陥りやすい

- メモリ使用量の増加

- 学習率の調整が難しい

小さい場合

利点

- 汎化性能の向上。flat minima に収束しやすく、これは汎化性能の向上に効果があると考えられている

- 局所最適解からの脱却

- メモリ使用量が少ない

欠点

- 学習時間の増加

- 勾配推定が不安定になる